Az elitet védi a Facebook cenzúraszabálya

A Facebooknak a gyűlöletbeszéddel és a politikai véleményekkel kapcsolatban is van egy iránymutatása a moderátorok felé, amelynek kiszivárgott egy része. A dokumentumot a ProPublica jelentette meg, az átfogó összefoglalójuk kivonatolt verzióját közöljük.

Ismét kiszivárgott egy belső dokumentum arról, hogy a Facebook milyen elvek mentén kontrollálja az oldalon megjelenő tartalmakat. Legutóbb egy moderátorok számára összeállított belső szabályzat került nyilvánosságra, amelyben a vállalat a szexuális, az erőszakos és a terrorizmussal kapcsolatos bejegyzésekre vonatkozó iránymutatásait részletezi. Ezúttal pedig a ProPublica jelentetett meg egy dokumentumot arról, hogy a cég algoritmusai és tartalomellenőrei mi alapján tesznek különbséget a gyűlöletbeszéd és az elfogadott politikai véleménykifejezés között.

A ProPublica egy amerikai nonprofit szervezet, amely nonprofit hírügynökségként definiálja saját tevékenységét, és ennek keretében oknyomozást folytat különböző közügyekben. A munkatársai teljes állású oknyomozó riporterek, akik olykor partnerekkel dolgoznak együtt egy téma kidolgozásán. Ebben az esetben a Facebook egyik belső dokumentuma jutott el a szerkesztőséghez, amely magyarázatot ad "a látszólag nem konzisztens döntésekre", hogy miért maradhat fenn érintetlenül az oldalon egy londoni politikustól vett idézet, amely a radikalizálódott muszlimok megölésére buzdít, és miért tilt ki a rendszer egy költőt egy hétre, aki szerint "minden fehér ember rasszista".

A Facebook az elmúlt évtizedben több száz szabályt hozott, hogy megkülönböztesse minek szabad megjelenni az oldalon és minek nem, annak érdekében, hogy az oldal egy "biztonságos hely" maradjon több mint 2 milliárd felhasználója számára. Az utóbbi időben viszont felmerült az álhírek témaköre és hogy a terroristák a közösségi oldalon toboroznak új tagokat, ami mind aggályossá teszi a rendszer használatát. A dokumentumok pedig arra mutatnak rá, hogy a Facebook gyűlöletbeszédre vonatkozó szabályai inkább az elitet és a kormányzatot védik, az alulról jövő aktivistákkal és a faji kisebbségekkel szemben. Ezzel pedig a vállalat a saját üzleti céljait akarja támogatni, hogy jó színben tűnjön fel a nemzeti kormányok előtt, és ne tiltsák meg a közösségi oldal használatát a polgáraiknak - mutat rá a ProPublica.

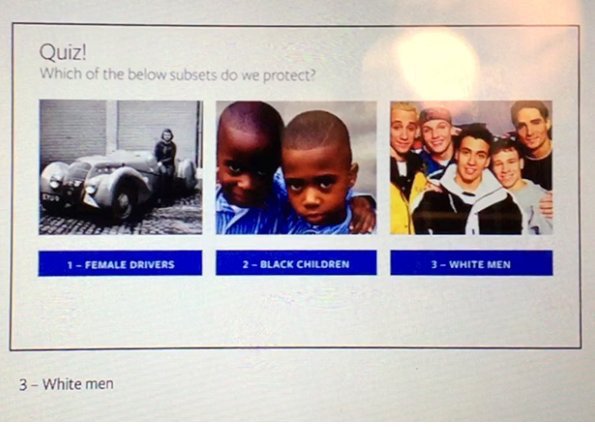

Gyűlöletbeszédnek a védett csoportok és az ellenük irányuló támadások együttesen számítanak a Facebook szerint. Védett kategória a nemi és vallási hovatartozás, illetve nemi identitás, a nemzetiség, a faj, az etnikum, a szexuális orientáció, továbbá a komoly fogyatékosság vagy betegség. Ellenben nem számít védettnek a társadalmi osztály, a kontinentális származás, a megjelenés, az életkor, a foglalkozás, a politikai ideológia, a vallások és az országok. Létrejöhetnek olyan alcsoportok is, amelyek két témát foglalnak magukba, ha ezek két védett csoportra irányulnak, akkor az védettnek számít, de ha egy védettre és egy nem védettre, akkor az a nem védett körébe fog tartozni. Tehát például az "ír származású nő" védett csoport, de az "ír tinédzserek" már nem azok. Ebből következik a képen szereplő következtetés is, hogy a női vezetők és a fekete gyerekek nem számítanak védettnek, ellentétben a fehér férfiakkal.

A szír bevándorlók miatt jött létre a Facebook szabályzatában a "kvázi-védett" kategória is, akik kapcsán a bevándorlókat az ellenük irányuló erőszakos felbujtás és a dehumanizáló megjegyzések ellen védi a közösségi oldal. Viszont a kirekesztő és az általános lealacsonyító megjegyzések előfordulhatnak az oldalon a migránsokkal szemben, a tartalom-ellenőrzőknek szóló teszt szerint például mocsoknak nem lehet nevezni a csoportot, de mocskosnak már igen. A támadástípusok közé egyébként az erőszakra és a szegregációra való felhívás, a kirekesztés, a megalázó általánosítás, az elutasítás (például "mind menjenek a pokolba"), a káromkodás vagy a gyalázkodás egyaránt besorolható.

A közösségi oldal általánosan arra törekszik, hogy minden fajt és nemet ugyanúgy megvédjen, nem csak a nőket vagy bizonyos kisebbségeket. Ez viszont Danielle Citron, a Maryland Egyetem jogi professzora szerint azt eredményezi, hogy a rendszer "azokat az embereket védi, akiknek a legkevésbé van rá szükségük, és eltávolítja azokat, akiknek valóban szüksége lenne rá." Erről Monika Bickert, a Facebook globális szabályozásért felelős igazgatója természetesen másként vélekedik, bár azt beismeri, hogy a szabályok nem mindig eredményeznek tökéletes megoldást. "Ez a valóság, mikor egy olyan világméretű közösségre szeretnék szabályokat alkalmazni, ahol mindenki különböző nézeteket vall arról, hogy mit szabad megosztani." - mondta. Így tulajdonképpen a vállalat egy saját világot teremtett magának, ahol globálisan a legtöbb ember jól érezheti magát.

(Forrás: ProPublica)

Egyébként a cég nem köteles cenzúrát alkalmazni a szolgáltatásban egy 1996-os amerikai szövetségi törvény szerint, amely a technológiai vállalatoknak "jogi immunitást" ad a felhasználók bejegyzéseivel kapcsolatban. Viszont a vállalatok hamar felismerték, hogy továbbra is felügyelniük kell a közzétett üzeneteket a zaklatás elkerülése miatt, ami távol tartaná a felhasználóikat a felülettől - a teljesen szabályozatlan közösségi szolgáltatások (mint a 4Chan) nem vonzóak a tömegek számára.

A Facebook azonban nem akar megfelelni más olyan országok törvényeinek sem, ahol működik. Például a Holokauszt tagadása Európában nem megengedett, de a Facebook egy belső vita után úgy döntött, hogy a felületein megengedi. Ha egy ország kormányzata szeretne eltávolítani egy tartalmat, akkor a Facebook első sorban azt vizsgálja meg, hogy az a saját szabályzatával ütközik-e, és csak utána azt, hogy az ország törvényeit megsérti-e, de utóbbi miatt nem feltétlenül távolítja el a bejegyzést, legfeljebb a földrajzi szűrést alkalmazza. Az pedig már korábban egyértelművé vált, hogy a cég kizárólag azokat a szabályozásokat veszi egyáltalán fontolóra, amit a helyi hatóságok nyomatékosan be is akarnak tartatni - pusztán a törvény betűje ehhez nem elegendő.

A Google már sokkal korábban bevezette YouTube-on a "geo-blocking" tiltást, amely csak bizonyos országok látogatói elől zárja el a tartalmat - mivel a vizuális tartalmak sokkal látványosabban mutatják be az erőszakot, mint a szavak. A Facebook azonban igyekszik elkerülni ezt a szűrést a bonyolultsága miatt, mert a felületén a felhasználók különböző országokból válaszolnak ismerőseiknek, és nem elég áttekinthető, ha különböző tartalmakat láthatnak. Ahol lehet, a vállalat inkább a szabályzatot módosítja úgy, hogy az megfelelő legyen a legtöbb embernek.

Több olyan földrajzi terület is van azonban, amely folyamatosan vitás kérdésnek számít a közösségben, például mikor Oroszország megszállta a Krím félszigetet, akkor az oldal több ukrán profilt letiltott, majd néhány tiltást feloldott és elnézést kért a tévedésért, mivel "a nyelvezet szabálysértőnek tűnt, miközben csak iróniát alkalmazott". Egy kijevi kommunikációs szakértő például egyszerre négy profillal van jelen, mert olyan sokszor letiltja valamelyiket az oldal: "mikor a háború elkezdődik, akkor az a Facebookon is kezdődik" - tette hozzá. Ugyanezt a helyzetet élik meg Nyugat-Szahara lakói vagy a palesztinok, akik saját címkét is bevezettek (#FbCensorsPalestine) a sokszor jogtalannak érzett letiltás miatt.

A helyzetet nehezíti, hogy a szabályzatok nem nyilvánosak, és az emberek nem tudják, hogy adott esetben miért távolította el az oldal a bejegyzéseiket, kivéve ha az egész profilt tiltja a rendszer. Többek közt Stacey Pattont, a baltimore-i Morgan State Egyetem újságíró professzorának profilját is gyakran letiltja a Facebook, miközben a döntést nem indokolja: "Ez olyan mint az érzelmi erőszak. Fekete személyként folyamatosan a tömeges bebörtönzésről beszélünk, és itt van ez a száloptikás tér, ahol kifejezheted magad. Aztán mondasz valamit, ami egy név nélküli személynek nem tetszik, és "börtönbe" kerülsz." - mondta.

(Forrás: ProPublica)

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

Ahogy már a múltkori szabályozói belső dokumentum megjelenése kapcsán is kifejtettük, a moderátoroknak nagyon nehéz helyzete van, sokszor mindössze tíz másodperc alatt kell dönteni arról, hogy egy bejegyzés mennyire elfogadható. A politika és a gyűlöletbeszéd pedig még érzékenyebb témakör, mint például a meztelenség. Mindössze annyit árult el Zuckerberg, hogy a korábbi 4500 fő mellé további 3000 főt vett fel a felhasználók által bejelentett tartalmakat figyelő Community Operations csoportba. A Facebook még azt tette most hozzá, hogy a szabályzaton kívül egy listával is rendelkezik olyan gyűlöletszervezetekről, amelyek nem jelenhetnek meg az oldalon, de ezt szándékosan nem teszi közzé.

Egy évvel azután, hogy a Facebook, a Microsoft, a Twitter és a YouTube elfogadta az Európai unió magatartási kódexét arról, hogy 24 órán belül eltávolítja az "illegális tartalmakat", az első decemberi audit eredménye azt mutatta, hogy a vállalatok a gyűlöletbeszédre utaló tartalmak 40 százalékát nézték át 24 órán belül, és csak 28 százalékát távolították el. Azóta a cégek csökkentették az átnézési időt, és növelték azoknak a tartalmaknak a számát, amelyet törölnek és cenzúráznak. A német kormány akár 50 millió eurós büntetést is kiszabna a Facebooknak, ha nem távolítja el elég gyorsan a gyűlöletbeszédet és az álhíreket - a vállalat egy válaszcikkben biztosította a német törvényhozókat, hogy egy hónap alatt 15 ezer német bejegyzést törölt ki, világszinten pedig az elmúlt két hónapban hetente 66 ezer bejegyzést.

Habár a Facebook törekvése önmagában nem elítélendő, hogy valamilyen rendszert próbál kialakítani a megfelelő és nem megfelelő tartalmak megjelenítésére, de a módszernek egyértelműen vannak hibái. A technológiai vállalatok cenzúráját is kutató Kate Klonick Yale doktorjelölt félelme szerint olyan hellyé fejlődhet a közösségi oldal, ahol a hírességek, a világ vezetői és más fontos személyek "aránytalanul nagy mértékben befolyásolhatják a szabályzatot" és így azt is, hogy milyen tartalmak láthatóak a havi 2 milliárdos felhasználószámmal rendelkező közösségi oldalon.