Így moderál a Facebook

Szeretné bemutatni a Facebook a problémákat és a nyilvánossággal segíteni a bántalmazott személyeknek, ezért nem törli az erőszakos képeket és videókat - legalábbis ezt állítja a nyilvánosságra került szabályzatai kapcsán. A szakértők szerint nagyobb átláthatóságra lenne szükség a moderátorok munkájáról.

Kiszivárgott dokumentumok alapján végre viszonylag pontos képet alkothatunk arról, hogy a Facebooknak mi az iránymutatása a szexuális, az erőszakos és a terrorizmussal kapcsolatos bejegyzésekre vonatkozóan. A The Guardian tanulmányozta és publikálta a közösségi oldal szabálykönyvének részleteit arról, hogy milyen tartalmak jelenhetnek meg a felületen és melyeket kell törölnie a moderátorcsapatnak. Az újságírók több mint száz belső oktatói kézikönyvet, táblázatot és grafikont néztek át, amelyek betekintést adtak, hogy a cég hogyan kezeli például a gyűlöletbeszédet, a pornográfiát, a rasszizmust vagy az önbántalmazást.

Mindig is érzékelhető volt, hogy a Facebook nehezen küzd meg a hatalmas méretű beáramló információ szűrésével - ezért is próbálta korábban kiszervezni a szélsőséges tartalmak monitorozását, de tényszerűség-ellenőrzést is külön bizottság végzi. Mint most kiderült, sokszor mindössze tíz másodperce van egy moderátornak dönteni arról, hogy egy bejegyzés mennyire elfogadható, ráadásul rendszeresen terjednek újabb kifogásolható tartalomtípusok.

Egy másik számmal érzékeltetve a mennyiséget, egy héten 6,5 millió jelentés érkezik be a moderátorokhoz olyan felhasználói profilokkal kapcsolatban, amelyek hamis adatokat tartalmaznak (fake accounts) - egy ilyenről érkeztek például az osztrák politikust sértő bejegyzések, amelyek miatt a párt perel. Vélhetően a munka mennyisége miatt vesz fel a cég további 3000 főt az oldalra kikerülő tartalmakat figyelő Community Operations csoportba is a jelenlegi 4500 tag mellé, amit Zuckerberg a legutóbbi pénzügyi negyedéves jelentés elemzői konferenciahívásán jegyzett meg.

A moderátorok számának bejelentése azért is volt fontos információ, mivel korábban semmit nem lehetett tudni a házon belül működő csapatról. Legtöbben alvállalkozóként dolgoznak közülük a világ különböző részein lévő központokban, de ezeknek helyéről és számáról a vállalat nem ad ki információt - írja a The Guardian. Minden munkatárs kéthetes képzést kap, illetve kézhez kapja a Facebook igazgatói által kidolgozott dokumentációt, amelyeknek most egy része kiszivárgott a sajtó felé. Ezek tartalmazzák az egyes jelenségek konkrét definícióit, illetve ezeknek megengedett és nem megengedett megjelenítését képekkel illusztráltan.

Emellett a közösségi oldal egy automatikus rendszert is alkalmaz a szélsőséges tartalmak szűréséhez, például a gyermekek szexuális bántalmazását vagy a terrorizmussal kapcsolatos tartalmak megjelenés előtti letiltásához - a folyamatnak ebben a szakaszában azonban a moderátorok nem vesznek részt. Ehelyett csak azoknak a bejegyzéseknek a millióit nézik át, amelyeket más felhasználók bejelentenek a rendszerben, ezt pedig egy speciális "egységes felülvizsgálati eszköz" (SRT) segíti - az esetek megítéléséhez a rendszeresen frissített kézikönyveket használják, kérdéses tartalmaknál egy felettesükhöz fordulhatnak. Ha egy felhasználó elítélendő tartalmat tesz közzé, akkor először csak figyelmeztetést kap a moderátoroktól - a szabályzat sorozatos megsértése azonban a profil lezárását is maga után vonhatja.

Ellentmondásos szabályok

Sok moderátor a megterhelő munka mellett amiatt is aggodalmát fejezte ki a The Guradiannek, hogy a szabályzat olykor sajátos és ellentmondásos, főleg a szexuális tartalmakkal kapcsolatban. Úgy foglalható össze az iránymutatás, hogy a Facebook "megengedi a szexuális gyönyör kifejezését, de nem engedi meg a nyílt szexuális részletek megjelenítését". Szabad például a ruhában szimulált szex, az elhomályosított részletek és a nyitott szájas csók szerepeltetése a fényképeken - tiltott azonban a szexuális játékok és más hasonló tárgyak ábrázolása "használat közben", viszont egyszerű lefényképezésük nem jelent problémát.

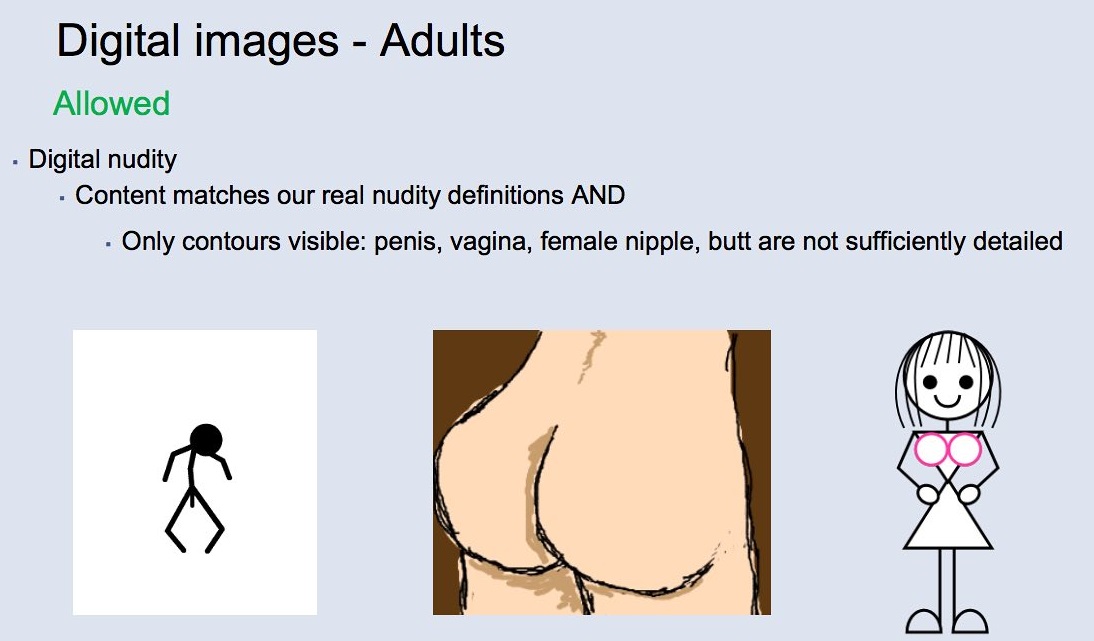

Tanult a közösségi oldal abból a hibájából is, hogy tavaly eltávolított a vietnámi háborúról szóló történelmi jelentőségű fotót, amelyen egy meztelen gyerek szerepelt, ezért külön dokumentum tartalmazza a meztelenség művészi ábrázolásáról szóló irányelveket, azonban a Facebook továbbra is "szürke zónának" tartja a területet. Az összefoglaló szerint a kézzel készített műalkotások minden esetben közzétehetőek a közösségben, azonban a digitálisan előállított szexuális illusztrációk közül csak a meztelenség ábrázolható, de különböző tevékenységek nem szerepelhetnek - a rajzolt és a digitális művészet megkülönböztetése pedig sokszor nehézségekbe ütközik.

A vietnámi háborús fotó kapcsán már engedélyezi az oldal a "háborús terrorról" szóló iránymutatás értelmében a "hírértékű kivételek" közzétételét, azonban a gyermekek meztelenségének ábrázolását a Holokauszt kontextusában továbbra is cenzúrázza. "Azt szeretnénk, hogy az emberek képesek legyenek megbeszélni a globális és aktuális eseményeket (...) így néha számít az a kontextus, amelyben egy erőszakos képet megosztanak". - nyilatkozta a Facebook szóvivője a The Guardiannek.

Egy erőszakos halálesetről szóló videót hiába jelölnek meg sokan zavaróként, azt nem minden esetben kell törölni a moderátornak, mivel az felhívhatja a figyelmet a problémákra, például a mentális betegségekre. Ugyanígy a gyerekek nem-szexuális fizikai bántalmazásáról és zaklatásáról is kinn maradhatnak a fotók, ha annak nincs szadista eleme, vagyis a célja definíció szerint "egy élőlény fájdalmának vagy a megalázásának a kifejezett élvezete" - ebben az esetben is az indok, hogy a gyereken akar segíteni a cég a nyilvánossággal. A "bosszúpornó" és a szexuális célzattal elkövetett zsarolás (sextortion) témakörében a Facebooknak egy hónap alatt összesen közel 54 ezer esetet kellett kiértékelnie, végül több mint 14 ezer fiókot tiltott le a közösségi oldal az ilyen típusú szexuális visszaélések miatt, amelyek közül 33 eset gyermekeket is érintett - írja a The Guardian.

Fenn maradhatnak továbbá a meztelenséget nem tartalmazó abortuszról szóló videók és az önbántalmazás élő közvetítése is, mivel "nem akarják cenzúrázni vagy büntetni a bajban lévő embereket". Az állatok bántalmazásáról szóló képek szintén közzétehetőek, kivéve a "rendkívül zavaróakat" vagy adott esetben fel lehet tüntetni, hogy a tartalom zavaró lehet a megtekintők számára.

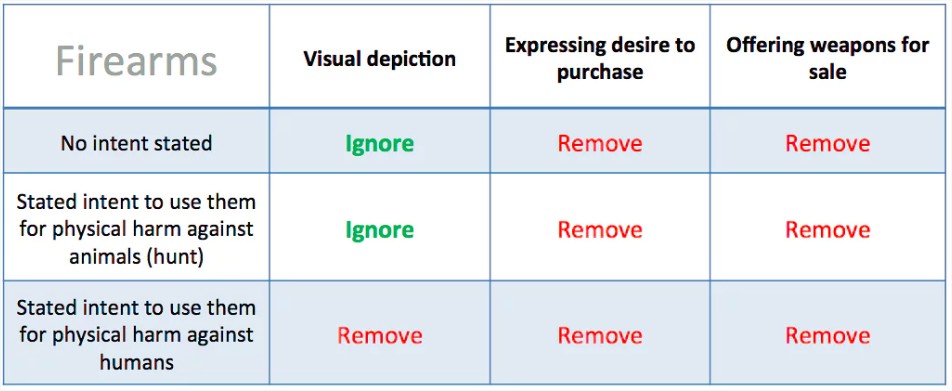

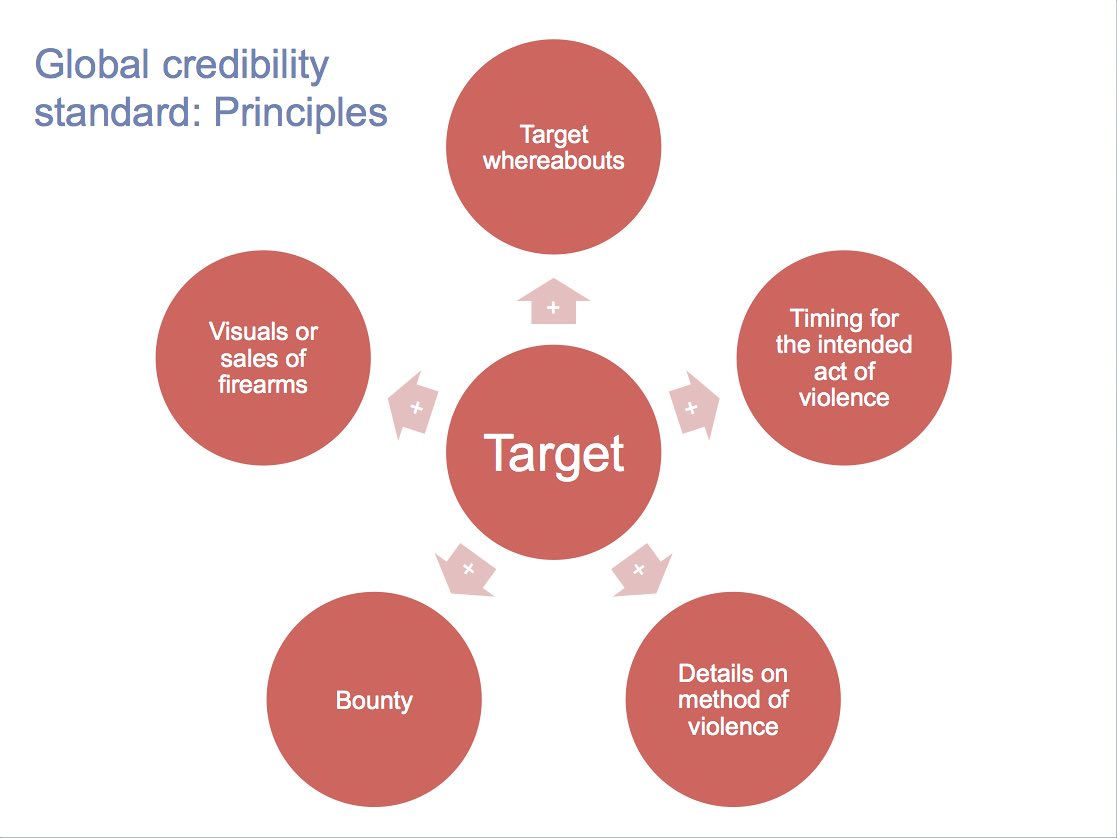

Érdekes ezenkívül, hogy a közösségi médiában több mint 100 ezer követővel rendelkező felhasználók már közéleti személynek, közszereplőnek számítanak, ezért nem illeti meg őket a magánszemélyek védelme. Viszont a kifejezetten sebezhető felhasználókról is listát vezet a közösségi oldal, ilyenek például az államfők és helyetteseik vagy jelöltjeik, a bűnüldözési tisztviselők, tanúk és informátorok, aktivisták és újságírók - a rájuk vonatkozó erőszak elkövetéséről szóló bejegyzéseket törölni kell, amennyiben ezekben személy szerint beazonosíthatóak, vagy megjelenik valahogyan a bűncselekmény időpontja.

Tavaszi mix a 2025-ös IT pangástól az interjúk evolúciójáig Ezúttal öt IT karrierrel kapcsolatos, érdekes és aktuális témát érintettünk.

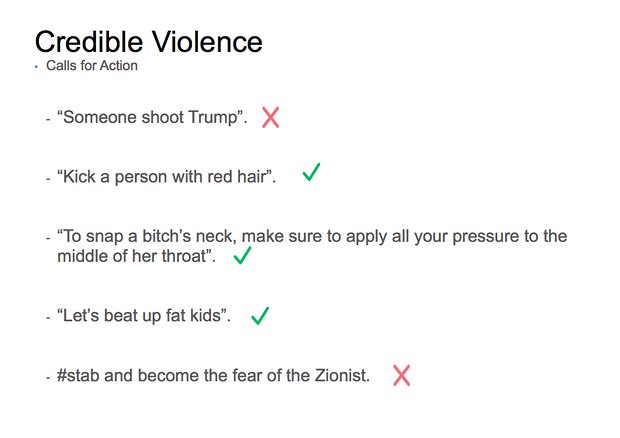

Általában káromkodni viszont szabad a felületen, mivel a vállalat elfogadja azt a tényt, hogy "az emberek erőszakos nyelvezetet használnak az online frusztráció kifejezésére". A szitkozódásba foglalt, mások testi sértésére vonatkozó kijelentéseket viszont addig nem tekinthetik fenyegetésnek a moderátorok, míg "a nyelvezet nem szolgáltat valós alapot arra, hogy már nem csak az érzelmek egyszerű kifejezéséről van szó, hanem a cselekmény leírásáról vagy megtervezéséről".

Kritikusok minden oldalról

Nem kétséges, hogy a szabályzat összeállítása nehéz volt a szerzőknek, mivel a legutóbbi adatok alapján 1,9 milliárdos közösséget a világ legkülönbözőbb részén élők alkotják, akik más-más normákkal rendelkeznek. "Igazán változatos globális közösséggel rendelkezünk, és az embereknek nagyon különböző nézeteik vannak arról, hogy mit OK megosztani. Nem számít, hol húzod a vonalat, mindig lesznek szürke területek. Például a szatíra és a humor, illetve a nem elfogadható tartalom között húzódó vonal néha nagyon szürke. Nehéz eldönteni, hogy átlépik-e a határt vagy nem." - mondta Monika Bickert, globális szabályzatért felelős Facebook igazgató.

Mentegetőzésképp Bickert azt is hozzátette, hogy a Facebook "egy új típusú cég. Nem hagyományos technológiai vállalat. Nem hagyományos médiavállalat. Technológiát építünk, és felelősnek érezzük magunkat azért, ahogyan használják. Nem mi írjuk a híreket, amelyeket az emberek a platformon olvasnak." Ez a típusú érvelés hasonló ahhoz, mint amelyet Zuckerberg a Facebook szűrőbuborék létezése és a félrevezető hírek kapcsán kommunikál, vagyis folyamatosan próbálja hárítani a cég felelősségét és elutasítja, hogy a tartalomfogyasztásra fókuszáló, hirdetéses üzleti modellben működő cég médiavállalat lenne.

A kritikusok egyik része szerint a Facebook kiadóvá vált a közzétett rengeteg kép és bejegyzés miatt, ezért jobban kellene figyelnie gyűlölködő és erőszakos tartalmak eltávolítására. Egy másik nézőpont szerint viszont a közösségi óriás szabályzata annyira szigorú, hogy az a szólásszabadságot korlátozza. Valószínűleg mindkét tábor leginkább az átláthatóságot hiányolja, amely részletesebben bemutatja a közösségi oldal szempontrendszerét, és hogy azt a vállalat mi alapján alakította ki. Ezt kifogásolta többek közt Yvette Cooper, brit politikus és a belügyminisztériumi bizottság korábbi elnöke is, aki szerint nagyibb átláthatóságot kellene biztosítani a szürke zónák felszámolásához, és szakértőket bevonni főleg a gyermekbántalmazások megítélésére vonatkozó kérdésekben.