Áthatolhatatlan lett a Facebook-szűrőbuborék?

Ellentmondás feszül a Facebook kommunikációjában: a cég algoritmusai hatékonyak a vásárlói döntések befolyásolásában, a politikai döntésekre viszont hatástalan. Mit mutatnak az adatok - létezik a hírhedt szűrőbuborék?

Érdekes kettősség figyelhető meg a Facebook kommunikációjában a saját befolyására vonatkozóan. Míg a cégek körében azzal népszerűsíti hirdetési megoldását a közösségi óriás, hogy nagy pontossággal tudja befolyásolni a felhasználók döntéseit, addig Zuckerberg cáfolja, hogy az oldalnak hatása lenne a politikai nézetekre, a félrevezető politikai hírekre, és így a közelmúltban lezajlott amerikai választásra.

Hatékony vagy sem?

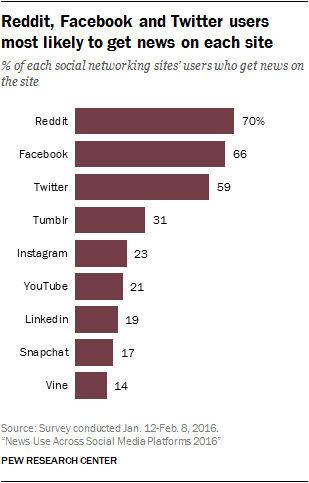

A szűrőbuborék-probléma az amerikai választások és annak eredménye kapcsán került újra az érdeklődés középpontjába. A Facebookot a választópolgárok túlnyomó többsége használja hírfogyasztásra (sokan pedig kizárólag innen tájékozódnak), így a kék testvér hatása vitathatatlan a felhasználók informáltságára. A Pew Research Center idei adatai szerint az amerikai felhasználók 66 százaléka a portálról értesül a hírekről, ami az Egyesült Államok lakosságának 44 százalékát jelenti. Különösen nagy forgalom jellemezte a választást, ahogy a HWSW is írt arról, 109 millió felhasználó 5,3 milliárd tevékenységet (bejegyzés, hozzászólás, megosztás, kedvelés) végzett ezzel kapcsolatban a közösségi oldalon. Ez rendkívüli hatalmat és persze felelősséget is jelent: a cég különböző algoritmusai, manuális és automatizált szűrői, különböző kísérletei és tesztjei ugyanis jelentős hatással bírnak.

A vádak szerint viszont a Facebook nem viselkedik annyira felelősségteljesen a hírek kezelésével, mint ahogyan azt a helyzet indokolná. Rengeteg megtévesztő hír jelenik meg a közösségi oldalon, amelyek ráadásul a szűrőbuborék miatt egyre jobban ellepik a felhasználók idővonalát. A buborék ezen kívül még azt is befolyásolja, hogy a felületen a liberálisoknak csak liberális, a konzervatívoknak pedig csak konzervatív tartalmak jelenjenek meg, ahogy a WSJ grafikáján is látszik - mindez az objektív tájékoztatással teljesen ellentétesen.

"Az a célunk, hogy azokat a tartalmakat mutassuk meg az embereknek, amelyek jelentőséggel bírnak számukra, és az emberek hiteles híreket akarnak. Már elkezdtünk dolgozni annak megoldásán, hogy a közösségünk tagjai megjelölhessék a megtévesztő és hamis híreket, és még ennél is többet tudunk tenni" - nyilatkozott a vezető egy Facebook posztban, hozzátéve, hogy ismereteik szerint ez csak a hírek 1 százalékát érinti. Arról már korábban írtunk, hogy az oldalnak meggyűlt a baja a politikailag elfogultnak bélyegzett hírszerkesztőkkel, és a félrevezető híreket kiválasztó, szintén elfogult algoritmusokkal a Trendek rovatban.

Közben a Facebook megtette az első lépést, tiltólistára teszi a félrevezető híreket közlő oldalakat, és nem engedi azokat hirdetni a felületén - akárcsak a Google. Ennél nagyobb port kavart, hogy a Gizmodónak nyilatkozó forrás szerint a cég már korábban tisztában volt a hamis hírek problémájával és házon belül el is készítette azt a szűrőt, amely a félretájékoztatásra szakosodott oldalakkal leszámolna - de a Facebook vezetése végül elvetette azt és nem élesítette az oldalon. A döntést az indokolhatta, hogy ez elsősorban a konzervatív oldalakat sújtotta volna, a cég pedig nem akarta magára haragítani a republikánus oldalt.

Ez a bejelentés megint ahhoz a kérdéshez vezet, amit az idézet első része is felvet, hogy a Facebooknak és általában az internetes szolgáltatásoknak mennyire van joga kiválasztani, hogy milyen információ bírjon jelentőséggel a felhasználók számára. Megerősítési torzításnak nevezik a pszichológiában azt a helyzetet, amelybe az internetező könnyen kerülhet, ha az algoritmusok folyamatosan csak a számára fontos, a nézeteit alátámasztó híreket válogatják össze a hírfolyamba - miközben az ellentétes véleményeket tejesen kiveszik a felhasználó látóköréből. Érthető, miért nehezményezik sokan, ha a politikai hírekből csak egyik vagy másik párt nézeteit jeleníti meg a felhasználói számára azaz oldal, ahonnan a választók a híreket fogyasztják. Mindez viszont nem csak az amerikai választásokat érinti, hanem bármely témában minden ország internetezőit.

Körbevesz a buborék

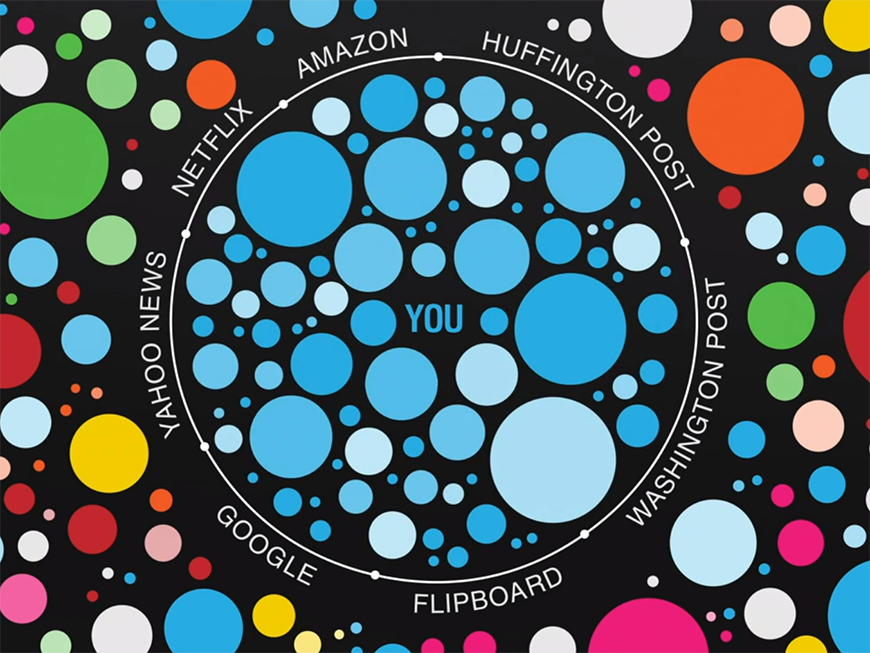

Már 2011-ben is foglalkozott Eli Pariser a jelenséggel The Filter Bubble: What the Internet Is Hiding from You című könyvében és egy TED előadásban, hozzá vezethető vissza a buborék-fogalom elterjedése is (más megközelítésből szokás echo-chambernek vagy Woozle-effektusnak is hívni), mely szerint mindenkinek van egy saját, külön bejáratú online információs világa, amelyben a tartalmakat a felhasználó korábbi tevékenységei alapján egy algoritmus választja ki. Egy olyan kényelmes hely, ahol csak azok az információk szerepelnek, amelyekre az adott felhasználó szívesen rákattintana.

"Az internet azt mutatja meg nekünk, amiről azt gondolja, hogy látni szeretnénk, és nem szükségképp azt, amit látnunk kell" - foglalta össze Pariser. Elég nagy probléma, hogy a felhasználók nem dönthetnek arról, hogy szeretnének-e bizonyos tartalmaktól eltekinteni az interneten, hanem az algoritmusok döntenek helyettük. Sőt, az emberek egy része nincs is azzal tisztában, hogy szűrőbuborékban él, és hogy bizonyos tartalmakkal nem szembesül - se a Facebookon, se a Google-ben, vagy akár más személyre szabott oldalakon. Ahogy Eric Schmidt, Google-igazgató fogalmazott egyszer: "Nagyon nehéz lesz az embereknek meglátni vagy használni bármit is, ami nincs valamiképp hozzájuk igazítva."

A Facebook számára az egyik legfontosabb mérőszám, hogy a felhasználók mennyi ideig használják az oldalt és milyen gyakran térnek oda vissza - akár napon belül is. Ahhoz, hogy ezt a mérőszámot maximalizálja, a cégnek igen finoman hangolt algoritmusokkal kell megteremtenie a felhasználó számára egy kellemes, vonzó felületet, amely az informáltság, jólértesültség illúzióját is megteremti. Ez pedig arra ösztönzi az oldal fejlesztőit, hogy a szűrőbuborékot ne építse le - épp ellenkezőleg, finomhangolja és tökéletesítse, ennek a szirénhangnak pedig nem biztos, hogy a cég ellen tud állni.

Zuckerberg cáfol

Elutasította a jelenség létezését Mark Zuckerberg a második negyedéves pénzügyi jelentést követő elemzői konferenciahíváson: "kutatási eredményeink azt mutatják, hogy a Facebook éppenséggel, és a közösségi média általában" az a hely, ahol a legkülönbözőbb nézetek megjelennek. Álláspontja szerint, ha a felhasználó ismerőseinek nagy része azonos háttérrel, politikai nézettel és vallási hittel rendelkezik, akkor is van közöttük 5-15 százalék ellenkező állásponttal rendelkező, és az ő hatásuk már megjelenik a hírfolyamban. Ez pedig sokkal több különböző vélemény megjelenését teszi lehetővé (legalábbis elméletben), mint a hagyományos média, amelyben a szerkesztők szabják meg a tartalmat.

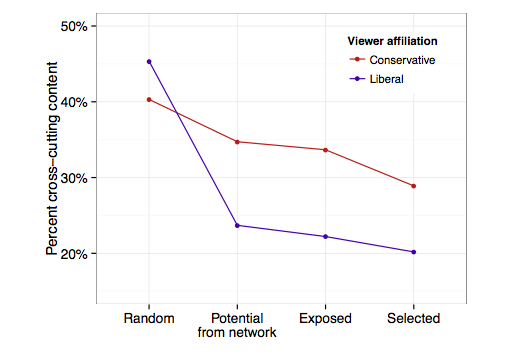

A hivatkozott Facebook-kutatást Eytan Bakshy, Solomon Messing és Lada Adamic publikálták a Science folyóiratban 10,1 millió amerikai felhasználó tevékenysége alapján (az összes amerikai Facebook-használó 4 százaléka), akik bejelölték a profiljukon, hogy saját magukat liberálisnak vagy konzervatívnak vallják. A kutatók a híreket osztályozták, hogy mennyire számítanak politikai tartalomnak (hard news) vagy inkább könnyedebbnek (soft news). Azok a hírek, amelyeket többségében az egyik oldalhoz tartozó emberek osztottak, megkapták a liberális vagy a konzervatív hangvételű címkét, majd a kutatók megfigyelték, hogy a hírek mennyire jelennek meg az ellentétes nézetű felhasználók hírfolyamában.

A vízszintes tengely értékei: Random: bármely felhasználó megosztása. Potential from network: ismerős ismerősének a megosztása. Exposed: a felhasználó valójában látta a tartalmat (algoritmus közrejátszik). Selected: a felhasználó rákattintott a tartalomra.

A kutatók konklúziója szerint az egyéni választások - hogy a felhasználó milyen tartalmakra kattint rá, mihez szól hozzá, illetve a felhasználó ismerősei mit osztanak meg - jobban számítanak a hírek megjelenésében, mint a rendszer algoritmusa. Összesen 6 százalékkal látnak kevesebbet a facebookozók olyan tartalmakból, amelyek a velük ellentétes nézeteket valló politikai oldalhoz tartoznak. Ahogy az ábrán is látszik, a tartalmat a hálózat (első és második adatpont közti lemorzsolódás), majd a felhasználó saját döntése (utolsó lépcső) befolyásolja, a megosztott és a megjelenített tartalom között (ami ténylegesen az algoritmus hatása) viszonylag kicsi a különbség.

A kutatók konklúziója viszont több szempontból megkérdőjelezhető - a "nem a mi hibánk" típusú kutatás megbízhatóságának és érvényességének problémái mellett -, hiszen az algoritmus pont a személyes választáson alapul, így felnagyítja azt a Cyborgology meglátása szerint. A buborék fogalmát megalkotó Pariser is kételkedik a következtetés helyességében, mondván ha "az algoritmus szűkítő hatása majdnem olyan erős, mint a tartózkodásunk a miénktől eltérő nézetektől, akkor az már egy nagy dolog".

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

Ráadásul a buborék-elméletnek csak egyik része volt, hogy az emberek a saját meggyőződésüket alátámasztó híreket látnak rendszeresen a hírfolyamban. A másik része viszont az, hogy nem találkoznak a demokratikus döntések meghozásához szükséges információkkal. Márpedig a kutatás bemutatta, hogy csak a felhasználók 7 százaléka kattintott a politikai (hard) hírekre, így a könnyedebb (soft) hírek hamar el tudják lepni a közösségi oldalt.

Magyar buborék

Magyar (és szlovák) viszonylatban is talált bizonyítékokat a Facebookon előforduló, felhasználói "szelektív választás" elméletére Dalibor Bobok, a CEU-n írt 2016-os politológiai szakdolgozatában. Kutatásában a közösségi oldalon 300 megosztott, politikai oldal szerint előre besorolt bejegyzés hozzászólásait és kedveléseit elemezte. Megállapítása szerint az olvasók 85-92 százalékban inkább az összhangban lévő tartalmakra reagáltak a disszonáns információkkal szemben, ami pontosan a szelektív választás egyik jellemzője.

A összeesküvés-elméleteket taglaló és szélső jobboldali bejegyzésekhez viszont nem csak azok szóltak hozzá vagy kedvelték, akik ideológiailag ehhez kötődnek - ez is bizonyítja, hogy az ő hírfolyamukon is megjelent a bejegyzés, tehát nem minden esetben érvényesült a buborék. A magyar politikai helyzet viszont nem egyszerűsíthető le úgy két oldalra, ahogy az amerikai liberális és konzervatív tartalmak, ezért inkább a politikai szövegkörnyezettől függtek a reakciók a vizsgált mintában, mint az ideológiai különbségektől. Arra viszont egyáltalán nem talált bizonyítékot a szerző, hogy a szelektív választás mértéke a hazai média töredezettségétől vagy polarizációjától függene.

Ideális algoritmus?

Ahogy Eli Pariser megállapította, az ideális az lenne, hogy a szűrő algoritmusok ne csak a relevanciát vegyék figyelembe számításkor, hanem a kényelmetlen, provokatív, fontos vagy más nézőpontokat bemutató gondolatokat is. Az algoritmus viszont nem nyilvános, ezért jelenleg egyáltalán nem tudjuk, mi alapján látja a felhasználó a hírfolyamban az adott tartalmakat és hogyan tudná ezt alakítani. Vagyis nincs lehetőség jelenleg arra, hogy a Facebook-fogyasztó (akár szándékosan) bővíteni tudja horizontját, bezártsága pedig kizárólag a fejlesztők szeszélyének függvénye.