Prototípusban a HPE vadiúj, memória-alapú rendszere

Mozgolódik a HPE legnagyobb kutatási-fejlesztési projektje, a The Machine. A sok éve fejlesztett rendszer kezd körvonalazódni, ugyanakkor jelen állás szerint kicsi az esélye, hogy ebben a formájában piacra kerül, valószínűbb, hogy egyes részeit külön-külön fogja monetizálni a cég.

Legyártotta The Machine fejlesztési projektjének prototípusát a HPE. A nagyjából 7 évet felölelő munka egy radikálisan új nagyvállalati rendszert takar, amely egy hatalmas kapacitású, a node-ok között megosztott memóriával próbál nagyot gurítani. Nem csak ez utóbb miatt érdekes a rendszer, abban ugyanis több más, széles körben még nem alkalmazott technológia találkozik, mint például az optikai-alapú adattovábbításhoz tervezett silicon photonics, vagy az ARM-alapú Cavium ThunderX2 processzor.

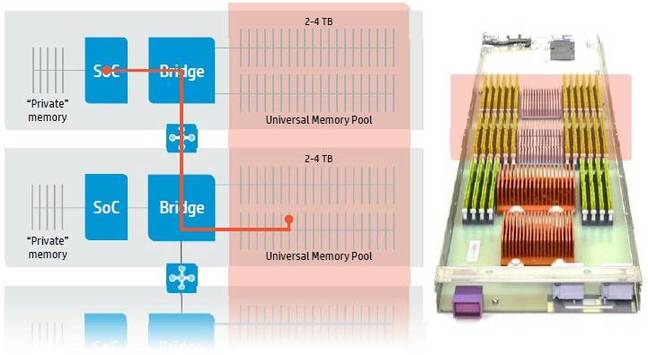

A The Machine-t a memória-alapú (memory-driven) rendszernek titulálja a HPE, az ugyanis egyetlen hatalmas, a prototipus esetében sok terabájtos, nem volatilis tárat oszt meg a rendszerben található összes processzormag között. A végrehajtók ebben az univerzális poolban található adatokkal végeznek műveleteket, helyben, ily módon pedig megtakarítható az egyes node-ok, illetve processzorok/gyorsítók közötti adatmozgatás, amivel felgyorsítható a rendszer működése, illetve növelhető annak hatékonysága.

Mindez első hallásra egyszerűnek hangozhat, a kivitelezés viszont koránt sem triviális. A megfelelő működéshez jóformán a rendszer összes elemét újra kell gondolni, a processzorok dizájnjától az interkonnekten át a protokollokig, a listából pedig olyan alapvető komponensek sem maradhatnak ki mint az I/O alrendszer, vagy maga a ház. És persze a jelenleg elérhető szoftverek sem ilyen architektúrához készülnek, emiatt a rendszeren futó operációs rendszer is egy kísérleti fejlesztés.

160 terabájtos prototípus

Az elkészült prototípus esetében 160 terabájtos a memória pool, amely kapacitás 40 fizikai node osztozik, ugyanakkor a memória pontos típusáról nem szól a fáma. A HPE eredetileg memrisztorral képzelte el a koncepciót, ugyanakkor a technológia ehhez továbbra sincs megfelelő állapotban, így ezt az opciót egyelőre kihúzhatjuk a listáról. Ezzel maradt a DRAM-ot és NAND-ot ötvöző Persistent Memory, illetve a PCM (Phase-Change Memory) technológia, ugyanakkor utóbbiban a HPE nem érdekelt, így ezt külső beszállítótól (Intel vagy Micron) kellene (kellett volna) megvásárolni. Amennyiben a rendszer valaha piacra kerül, úgy az várhatóan a memrisztorral történik majd, ugyanis ezzel a technológiával aknázható ki a koncepcióban rejlő legnagyobb potenciál.

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

A node-ok, illetve az azokban található processzorok optikai-alapú, photonics interconnect kapcsolaton keresztül érintkeznek a hatalmas kapacitású memória poollal, amivel optimális esetben jelentősen minimalizálható a hozzáférés késleltetése. Ez a fajta megközelítés nem egyedi, az Intel ugyancsak évek óta dolgozik Silicon Photonics nevű fejlesztésén, az erre alapuló rendszerekhez szükséges komponenseket pedig már szállítja a processzorgyártó.

Korábban kérdéses volt, hogy a HPE milyen központi egységekkel képzeli el a rendszert. Bár egyelőre csak prototípusról van szó, a tervezőcsapat az imént említett Intel valamely megoldása helyett inkább az egyelőre nem túl ismert Cavium második generációs ARM-alapú platformja mellett tette le a voksát. A ThunderX2 platformról egyelőre nem sokat tudni, az legutóbb a Microsoft Project Olympus projektjének kapcsán bukkant fel a hírekben, a vállalat ugyanis több más mellett erre is épít. A Cavium első generációs megoldása meglehetősen gyengén muzsikált a független tesztekben, számítási teljesítményt és fogyasztást tekintetében is bőven akadtak problémák, amelyek nagy részét remélhetőleg orvosolták a második kiadásban.

A HPE korábbi tájékoztatása alapján a The Machhine rendszerchipjei rendelkeznek saját, úgynevezett privát memóriával is, amihez az alkalmazások közvetlenül nem férhetnek hozzá, így az gyakorlatilag gyorsítótárként működik. A nagy méretű, univerzális poolt pedig egy hídon, illetve egy lokális fabric switchen keresztül érhetik el az egyes processzorok.

A szoftver mint sarkalatos pont

Bár a hardver megtervezése sem sétagalopp, legalább ekkora kihívást jelent az új architektúra kiaknázása, azaz a megfelelő szoftveres környezet kialakítása. A munkát meglehetősen mélyről kell kezdeni, a manapság széles körben alkalmazott rendszerekhez viszonyítva ugyanis jelentős az eltérés, amihez elsőként az operációs rendszert kell átszabni, hisz az operatív tár és a háttértár viszonya gyökeresen változott. A HPE ehhez egy Linux-alapú megoldást készített, de erről egyelőre nem árult el pontosabb részleteket a cég.

Az operációs rendszer mellett az alkalmazásokat is gyakorlatilag alapjairól kell újraírni, azokkal csak így aknázható ki a The Machine potenciálja, az operatív tár és a háttértár egybeolvadásával a programoknak már csak egyetlen nagy memóriaterületet kell címezniük. Ehhez a HPE már tavaly kérte a szabad szoftveres közösség segítségét, hogy annak tagjai vegyenek részt az új koncepcióra épülő The Machine szoftveres környezetének kidolgozásában.

Lesz-e piacképes verzió?

Arról egyelőre nincs pontos hír, hogy a HPE legnagyobb kutatási-fejlesztési projektjének számító The Machine valaha piacra kerül-e, vagy az majd csupán kísérleti egérként végzi. Az egyes fejlesztéseknek külön-külön is van relevanciájuk, a vállalat azokat később önmagukban is felhasználhatja egyes termékeiben. A memória-alapú megközelítés például a Big Data feldolgozáshoz nyújthat ideális alapot, a nem volatilis memóriák térnyerésével pedig a konkurenseknek is hasonló házi feladatot kell elvégezniük. Arról egyelőre korai lenne beszélni, hogy sok éve futó, dollár tízmilliókat felemésztő The Machine projekt ebben pontosan mekkora előnyt nyújtott a HPE-nek, erre majd csak az egyes fejlesztések piacképes verziói adhatják meg az első választ.