Útnak indult a Meta AI asszisztense is

Majdnem minden szolgáltatásában lehet majd használni a Meta AI-asszisztensét, miközben megérkezett a cég új nagy nyelvi modellje, a Llama 3 is.

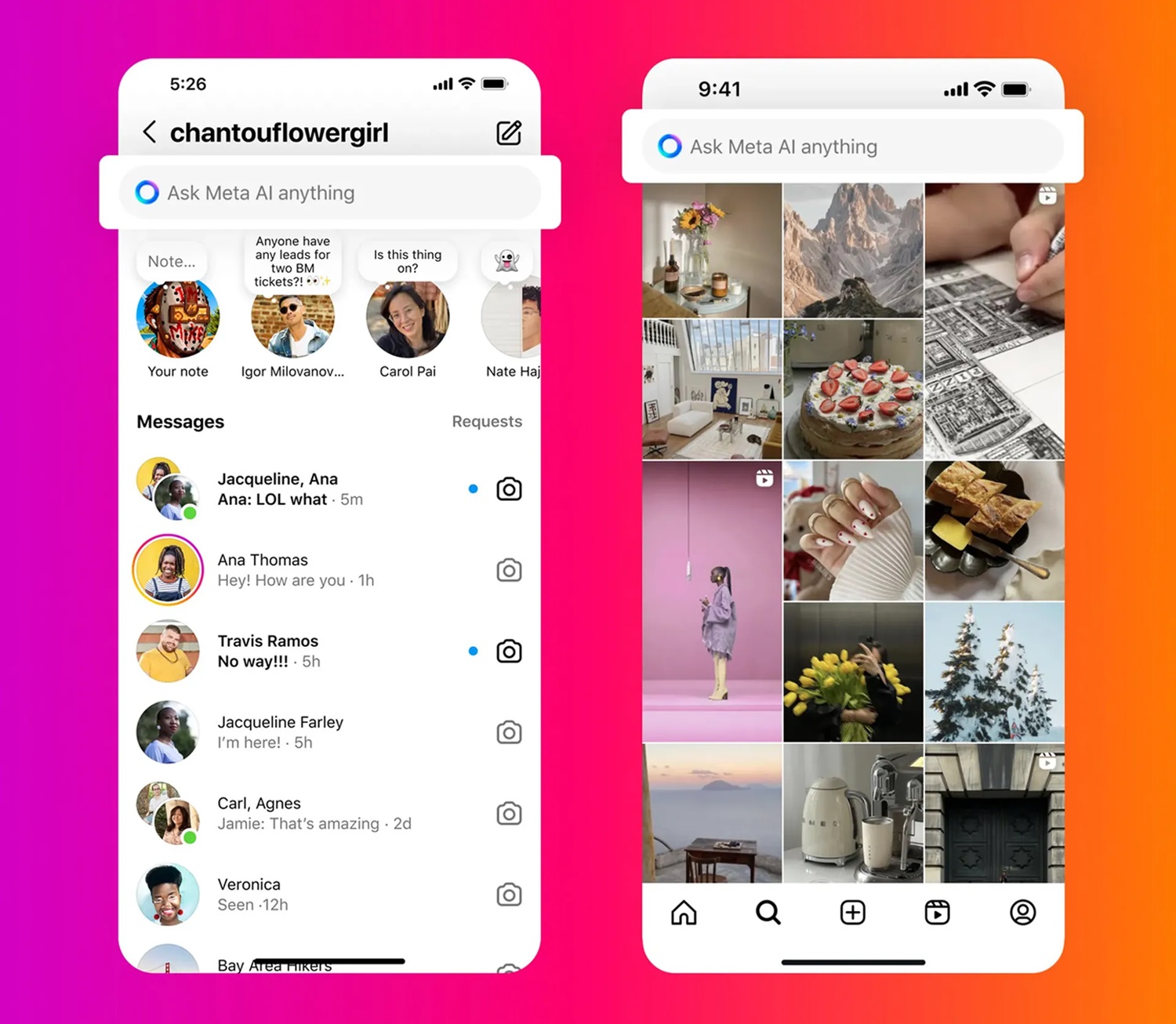

A WhatsApp, az Instagram, a Facebook és a Messenger szolgáltatásokba is beépül a Meta csütörtökön útnak indított mesterségesintelligencia-asszisztense, a Meta AI, ami a cég eddigi legmarkánsabb lépése a felkapottnak számító, fejlődő területen.

A kérdésekre párbeszédes formában válaszoló, emellett képeket és animációkat generáló eszköz az OpenAI ChatGPT és a Google Gemini versenytársaként érkezik, annyi csavarral, hogy a Meta a Google-lel és a Microsofttal is megállapodott arról, hogy a fejlesztése mindkét rivális techcég keresőjéből behúzza a találatokat, ezzel pedig gyakorlatilag az egyetlen olyan chatbot a piacon, ami valós időben szerzi meg az információkat és találatokat.

Az asszisztens a közösségi óriás legújabb nagy nyelvi modelljére, a Llama 3-ra épül, ami a cég állítása szerint a kulcsfontosságú benchmarkokban felülmúlja a rivális modelleket, és minden szempontból jobban teljesít azoknál olyan feladatokban, mint a kódolás.

USA Tech Hub: ahonnan a passzátszél fúj Minden, ami a technológiai szektorban történik, jellemzően az USA-ból indul.

A megoldást támogató Meta-szolgáltatásokban kézenfekvő mód az appok keresőmezőiben tehetik fel a felhasználók kérdéseiket, például kérhetik az éttermekre vonatkozó ajánlásokat, vagy segítséget kérhetnek egy utazás megtervezéséhez. De használható lesz a Messengeren belül és közvetlenül a Facebook hírfolyamban is.

Az asszisztens bővített funkcionalitással a „meta.ai” weboldalon különálló alkalmazásként érhető el, ahol a folytatott párbeszédek naplózhatók későbbi felhasználás céljából. Ezen a felületen lehet használni a képgenerálási képességet béta verzióban, amit ezen felül egyelőre még a WhatsAppban tesztelnek.

Az asszisztens a bejelentéssel tucatnál több országban élesedett angol nyelven, köztük az Egyesült Államokban, Kanadában, Új-Zélandon és Ausztráliában, de Magyarországon egyelőre még nem.