AI Act: nehéz lesz belekalkulálni a bírságokat a büdzsébe

Horváth Katalin, a CMS Budapest senior ügyvédje szerint a húzós bírságok kellőképpen ösztönözhetik a szervezeteket majd arra, hogy betartsák az uniós AI Act követelményeit, de a törvény az értéklánc szereplői közt is különbséget tesz abban, hogy kire milyen mértékben vonatkoznak az előírások.

Több mint egy hónapja, március 13-án az Európai Parlament technikailag végére ért a mesterséges intelligencia megoldások működését szabályozó „AI Act” jogszabály hosszadalmas törvényalkotási-ratifikálási folyamatának. Az AI Act (AIA) a végszavazáson igen 523 szavazattal, 46 ellenében, 49 tartózkodás mellett ment át a törvényhozáson, így a formálisnak tekinthető nyelvi lektorálást követően következhet a kihirdetés, melyre a várakozások szerint valamikor májusban kerülhet sor.

A törvény ezt követően 20 nappal lép hatályba és ahogy az ilyenkor lenni szokott, ad bizonyos türelmi időt az érintett entitásoknak (magáncégek, állami szervek) arra, hogy megfeleljenek a benne foglaltaknak. Ez az AIA esetében többlépcsős, így van olyan rendelkezés, amit fél éven belül alkalmazni kell (tiltott rendszerek), a magas kockázatú mesterséges intelligencia-megoldásoknál pedig 36 hónap lesz a türelmi idő. A jogalkotók 12 hónapot adtak a hatóságok értesítésére és az általános célú kötelezettségekre, illetve 24 hónapot minden más rendelkezésre.

Az EU emelt egyet a téten GDPR-bírságokhoz képest, mivel aki "tiltott" AI-t fejleszt, forgalmaz, használ, az akár legfeljebb 35 millió eurót (kb. 13,8 milliárd forint), vagy az éves világpiaci forgalma 7 százalékát kaphatja büntetésként.

A "magas kockázatú" AI rendszerekre vonatkozó kötelezettségek megszegéséért járó maximális bírságot 15 millió euró (kb. 5,9 milliárd forint)/éves világpiaci forgalom 3 százalékában határozták meg, míg a tájékoztatási kötelezettségek megsértése esetén 7,5 millió euró/1 százalék forgalom a felső határ.

Az általános célú AI-rendszerek (GPAI) szándékos vagy gondatlan megsértésekor pedig 15 millió euró/3% forgalom a plafon.

A bírságtételek kellőképpen ösztönözhetik az érintetteket arra, hogy betartsák a rendelkezéseket, mivel ezeket már nem feltétlenül lehet majd belekalkulálni az éves büdzsébe"

- véli Horváth Katalin, a CMS Budapest szenior ügyvédje, aki az IVSZ által szervezett idei SMART konferencián próbálta értelmezhetőbbé tenni az új jogszabályt, és elmagyarázni, mit fog ez jelenteni a gyakorlatban.

Mire lesz érvényes?

Az alkalmazott definíció szerint az AI rendszer „olyan gépi alapú rendszer, amelyet úgy terveztek, hogy különböző szintű autonómiával működjön, és amely explicit vagy implicit célok érdekében olyan kimeneteket, például előrejelzéseket, ajánlásokat vagy döntéseket képes generálni, amelyek befolyásoljákj a fizikai vagy virtuális környezetet”. A rendszer emberi beavatkozás nélkül működik, öntanuló, a bemenet gépi vagy emberi alapú is lehet. Kivételt képeznek az előírások alól a kizárólag tudományos kutatásra és fejlesztésre, illetve a katonai, védelmi és nemzetbiztonsági tevékenységekben használt AI-rendszerek.

A kockázatalapú megközelítést bevezető szabályzat több kategóriát nevez meg, a minimálistól kezdve a magas kockázatig, így értelemszerűen az alacsony kockázatú felhasználási esetek nem igénylik a szigorúbb szabályozási kereteket, míg a magas kockázat átfogó dokumentálásra, tesztelésre és egyéb biztonsági intézkedések megtételére kötelezi a fejlesztőket.

Elfogadhatatlan kockázatúnak számítanak például az olyan MI-rendszerek, amelyek egyértelműen veszélyeztetik az emberek biztonságát, megélhetését és jogait, ezeknek az alkalmazása a rendelet értelmében be lesz tiltva. Ide tartoznak az olyan MI-rendszerek vagy -alkalmazások, amelyek a felhasználók szabad akaratának megkerülése érdekében manipulálják az emberi viselkedést (pl. játékok, amelyek hangasszisztens-szolgáltatások révén a kiskorúakat veszélyes viselkedésre ösztönzik) és olyan rendszerek, amelyek lehetővé teszik a kormányok általi „társadalmi pontozást”.

Platón ragadt informatikusok klubja Egyetlen más szakma sincs, ahol olyan gyorsan el lehet érni a karrier-platóra, mint az IT. A midlife, a mid-level mellett létezik mid-career krízis is.

A magas kockázatúnak minősített MI-rendszerek közé tartoznak többek közt a kritikus infrastruktúrák, az oktatás és szakképzés, az alapvető magán- és közszolgáltatások, a bűnüldözés és az igazságszolgáltatás területén alkalmazott technológiák. A Horváth Katalin által hozott gyakorlati példák említik azokat a rendszereket, amelyeket az oktatásban használnak a vizsgáztatás, a felvételi eljárások, az értékelések során, de ide tartoznak például az üzleti életben alkalmazott érzelemfelismerő rendszerek, vagy a biometrikus azonosítás, a bankszektorban pedig a hitelképesség értékelésének folyamata, ám kiemelte, hogy a csalások detektálásához használt eszközökre nem vonatkoznak az előírások.

A magas kockázatúnak minősített rendszerek üzemeltetőire számos kötelezettség vonatkozik majd:

- kockázatkezelési keretrendszer létrehozása,

- a rendszerekhez tartozó műszaki dokumentáció gyártása,

- automatikus naplózás bevezetése,

- emberi felügyeletről való gondoskodás.

A cégeknek teljes megfelelőségi értékelést kell végezniük: választhatnak a megfelelőség értékelési eljárás vagy az uniós harmonizált szabványnak való megfelelés közt. Horváth szerint utóbbi esetben könnyebb dolguk lesz, de a tanúsítványokat 4-5 évente meg kell majd újítani.

Feltétel lesz továbbá az uniós megfelelőségi nyilatkozat kiadása és a CE jelölés, valamint regisztráció az EU AI adatbázisában. A GDPR-ban előírtakhoz hasonlóan a szervezeteknek kötelező lesz jelenteniük a biztonsági incidenseket: a nagy kockázatú biztonsági incidensek bejelentésére 15 nap áll rendelkezésre a meghatározott hatóságok felé, de mindössze 2 nap alatt jelezni kell a létfontosságú infrastruktúrát érintő eseteket.

Az átláthatósági tájékoztatási követelmények közt szerepel, hogy a médiában jelölni kell az AI által generált tartalmak megjelenítésekor, hogy nem ember által alkotott tartalomról van szó, ugyanez érvényes a deepfake-ekre.

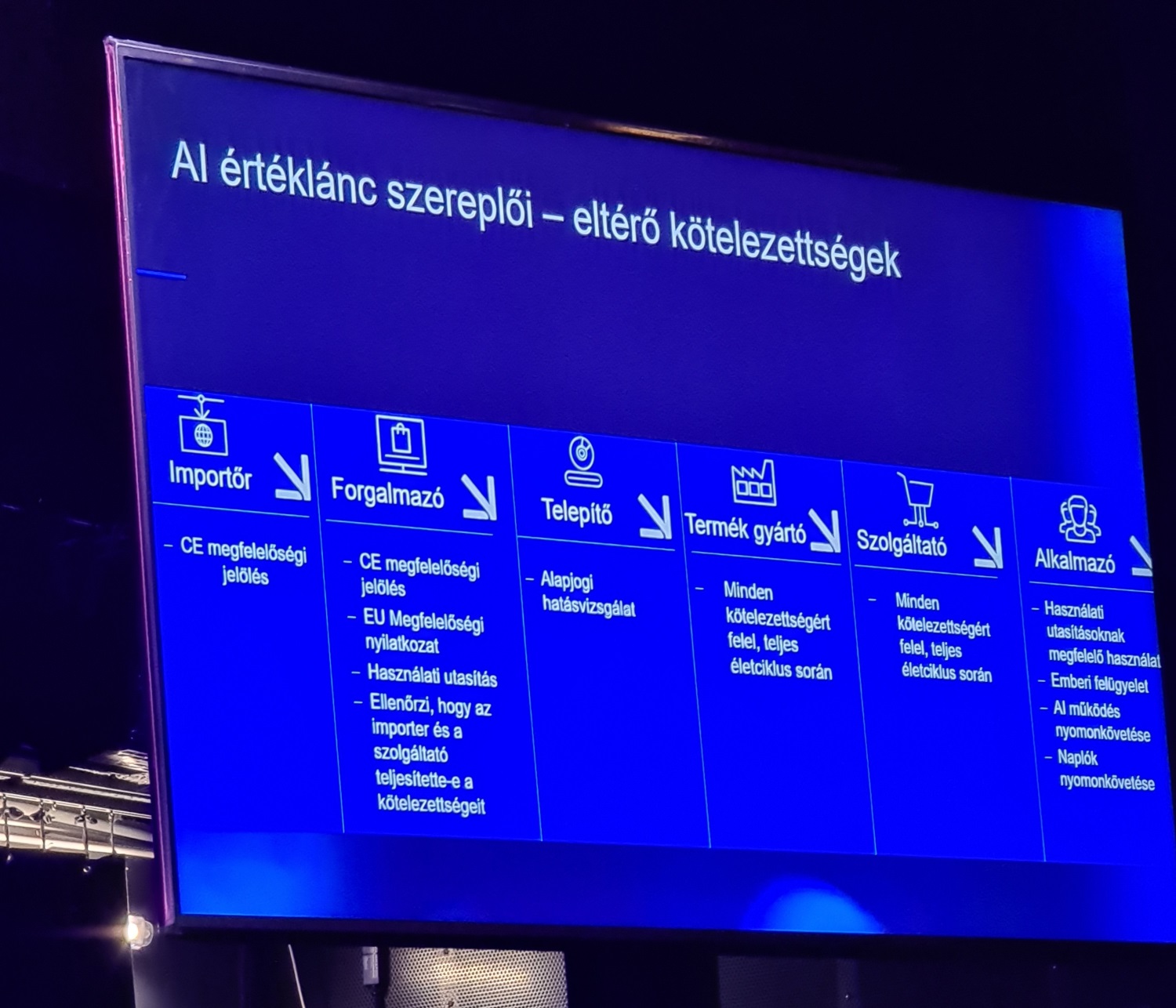

Nem mindegy, ki hol áll a láncban

Az AI Act az értéklánc szereplői közt is különbséget tesz abban, hogy kire milyen mértékben vonatkoznak a követelmények. A telepítőknek például csak alapjogi hatásvizsgálatot kell végezniük, az importőröknek CE megfelelőségi jelölés megszerzése szükséges az EU-ban való forgalomba hozatalhoz. Míg egy forgalmazónak ezek mellett használati utasítást is kell írnia az általa forgalmazott megoldáshoz, és ellenőriznie, hogy az importőr és a szolgáltató teljesítette a kötelezettségeit.

Adott termék gyártója minden kötelezettségért felel a teljes életciklus során, ami érvényes a szolgáltatóra is. Az adott AI rendszer alkalmazójára is vonatkoznak majd előírások, például hogy a használati utasításoknak megfelelően használhatja az eszközt, és garantálnia kell az emberi felügyeletet, nyomonkövetnie a működést, és neki kell gondoskodnia arról, hogy a naplózás megtörténjen.

A jogszabályban külön kategóriát képez a general purpose, azaz általános célú AI (GPAI), amely alatt olyan általános célú AI rendszereket értenek, amik általános célú modelleken alapulnak, ilyen a felhasználók széles köre által használt ChatGPT vagy a Copilot szolgáltatások. Az ilyen megoldások fejlesztőinek technikai dokumentációt kell gyártaniuk, és tájékoztatót benyújtani arról, milyen tartalmakat dolgozott fel a generatív AI. Mindemellé plusz követelmények jönnek még, ha rendszerkockázatot jelentő GPAI-ról van szó: például a modellértékelés, a rendszerkockázat értékelés, az incidensek jelentése és dokumentálása.

"Azt még nem tudni hivatalosan, hogy Magyarországon ki lesz a tagállami AI hatóság" - tette hozzá Horváth Katalin. Európai szinten már rajzolódnak a főbb szereplők: az EU Bizottságon belül egy AI Hivatal felel az iránymutatások kiadásáért, míg az AI Board testület ajánlásokat és véleményeket fogalmaz meg, miközben egy Tanácsadó Fórum és Tudományos testület segíti a munkát. Tagállami szinten kell egy hatóság, ami a bejelentéseket kezeli, és egy piacfelügyeleti hatóság, Magyarországon jó eséllyel egy hatóság felel majd mindkét szerepkörért.