Itt a Blackwell, ipari forradalomról beszél az Nvidia

Az Nvidia H100-as AI-gyorsítóchipjeivel a mai napig nemigen tud mit kezdeni a konkurencia, a cég erre bejelentette a bizonyos műveletekben akár 30-szor gyorsabb Blackwell sorozatú chipeket, hogy még tovább növelje előnyét, illetve ezzel párhuzamosan a vállalat értékét.

Az Nvidia megkerülhetetlen tényező a generatív nagy nyelvi modellt használó mesterséges intelligencia megoldások szegmensében, hiszen a vállalat hosszú évek óta az egyetlen cég, mely képes a grafikus gyorsítók piacán felépített tudásbázisának köszönhetően óriási teljesítményű AI-gyorsítókat gyártani, ráadásul kellő mennyiségben.

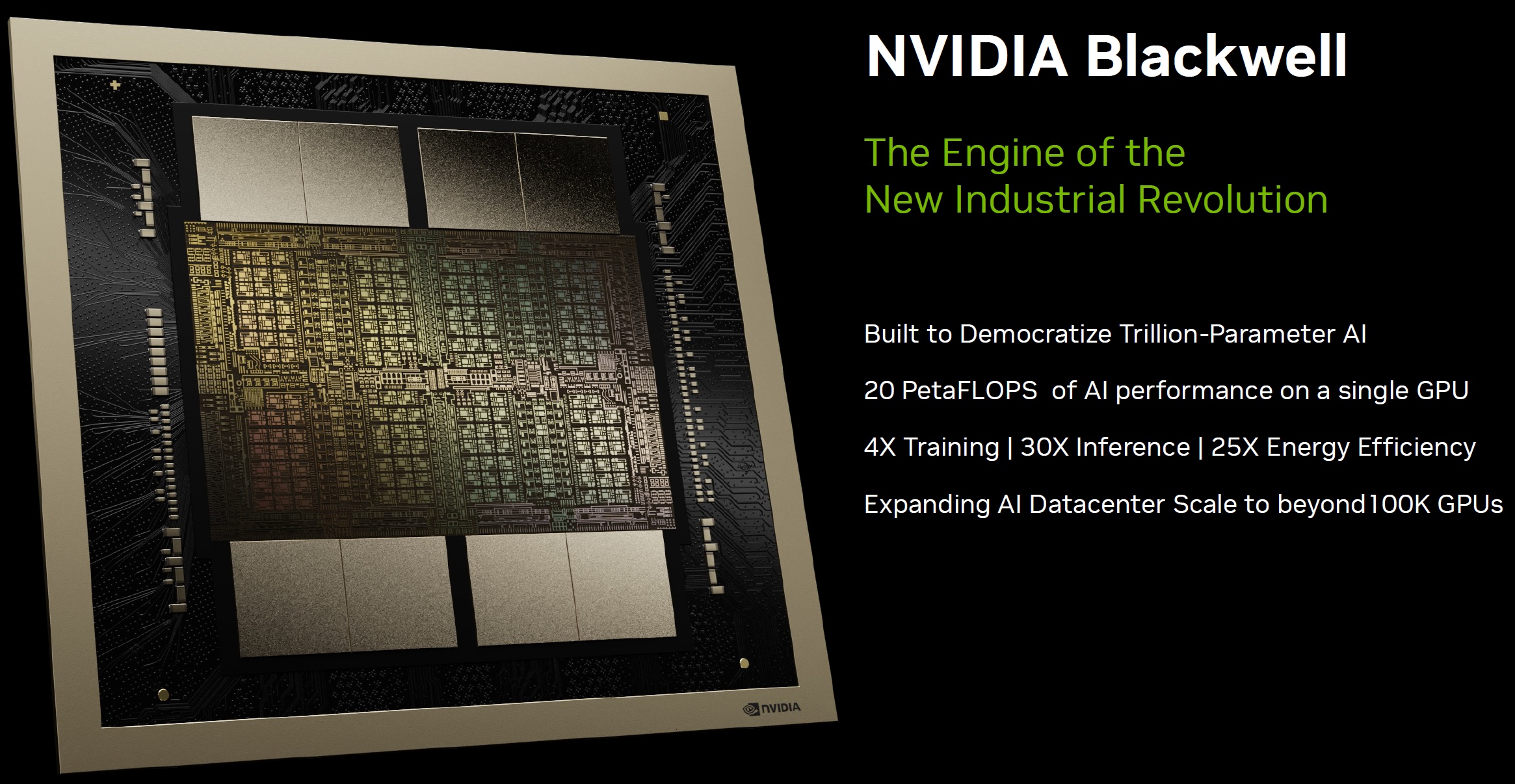

A társaság hétfőn bejelentette az AI-célfeladatokra optimalizált gyorsítóchipjeinek legújabb generációját, a Blackwellt, mely ezúttal is egy GPU-ból (B200) és egy két GPU-t és egy Grace CPU-t tartalmazó "szuperchipből", a GB200-ból áll.

Ipari forradalmár

Az Nvidia ezúttal sem aprózta el a fejlesztéseket, így a B200/GB200 páros a műveletek jellegétől függően - papíron legalábbis - legalább hétszer, de akár harmincszor nagyobb számítási teljesítménnyel rendelkezik, mint közvetlen elődje, a H100/GH100, miközben áramfelvétele akár azok töredéke.

A tegnapi bemutatón Jensen Huang, a cég vezérigazgatója ezt egy konkrét példával is igyekezett szemléltetni, így míg egy 1,8 billió paraméterrel rendelkező modell egységnyi idő alatt történő feltanításához 8000 Hopper GPU-ra és 15 megawattnyi áramra volt szükség, addig ugyanezt a feladatot, ugyanennyi idő alatt képes 2000 Blackwell GPU ellátni 4 megawattnyi áramfogyasztás mellett.

A bemutató ennek megfelelően bővelkedett az olyan, önbeteljesítőnek tűnő jóslatokban, mint amikor Huang a konferencia nyitóelőadásában kijelentette,

a Blackwell GPU-k lesznek a motorjai az új ipari forradalomnak.

Hozzátéve, hogy a generatív AI korunk olyan, meghatározó technológiája, mely a világ "legdinamikusabb" vállalataival karöltve képes lesz minden iparág számára előnyt teremteni.

USA Tech Hub: ahonnan a passzátszél fúj Minden, ami a technológiai szektorban történik, jellemzően az USA-ból indul.

A Blackwell chipek - melyek David Harold Blackwell matematikus után kapták a nevüket - elméletileg 20 petaflopsnyi FP4 számítási kapacitással rendelkeznek, ami ötszöröse a H100-as teljesítményének, a valójában két chipből "összeragasztott" B200 pedig összesen 208 milliárd tranzisztorból áll, szemben a H100-zal, mely 80 milliárd tranzisztorból épül fel.

Hogy a cég megoldásaira mennyire rá vannak utalva a legnagyobb iparági multik, azt kitnűnően szemlélteti, hogy a Blackwell chipekről szóló sajtóközlemény a világ legértékesebb technológiai cégeinek vezérigazgatóitól idéz (az egyetlen hiányzó jóformán Tim Cook), így megszólal az új termék kapcsán egyebek mellett Mark Zuckerberg (Meta), Satya Nadella (Microsoft), Sundar Pichai (Google/Alphabet), Larry Ellison (Oracle), Michael Dell (Dell) és Elon Musk (Tesla) is.

DGX-ben az erő

Az Nvidia a fenti cégeknek nagyobb, "kulcsrakész" kiépítésben, konfigurációkban is kínálja majd a Blackwell megoldásokat, ilyen lesz egyebek mellett a GB200 NVL72, mely 36 CPU-val és 72 GPU-val egy 720 ptaflops számítási teljesítménnyel rendelkező szörnyeteg, de lesz DGX-megoldás is (DGX GB200), akár 288 CPU-val és 576 GPU-val, 240 TB memóriával - mai szemmel meglehetősen szürreális, 11,5 exaflopsnyi FP4 számítási kapacitással.

A Blackwell chipeket tartalmazó rendszerekből az Amazon, a Google, az Oracle és a Microsoft egyaránt berendelt már nagyobb mennyiségben, a szállítási időről és az árról ugyanakkor egyelőre szemérmesen hallgat az Nvidia - de tekintve, hogy egyetlen H100 gyorsító ára valahol 25 és 40 ezer dollár közé tehető, a B200 és GB200 chipekért ennek az összegnek akár a többszörösét is elkérheti a gyártó.