Az Nvidia nyakán az AMD az adatközpontokban

Nem dőlhet hátra kényelmesen az Nvidia, mely a mesterséges intelligencia modellekhez használt adatközponti gyorsítók legnagyobb gyártója ma a világon, mivel az AMD ismét tanúbizonyságát tette annak, hogy az adatközponti megoldások szegmensében képes rendkívül versenyképes megoldásokkal előállni.

Komoly szerepet szán magának az AMD az adatközponti processzorok (AI-modellek feltanítására optimalizált gyorsítók és általánosabb célú feldolgozóegységek) szegmensében, ahol jelenleg ezeken a területeken szinte egyeduralkodónak számít az Nvidia, a vállalat egyik legősibb riválisa. A két cég egyaránt elsősorban a gaming szegmens növekedése, illetve a grafikus feldolgozóegységek piacán folytatott fejlesztéseknek köszönhetően érkezett el oda, hogy ma brutális teljesítményű célprocesszorokat szállít adatközpontokba, az AMD megoldásainak teljesítménye ugyanakkor többnyire nem érte el a riválisét - egészen mostanáig.

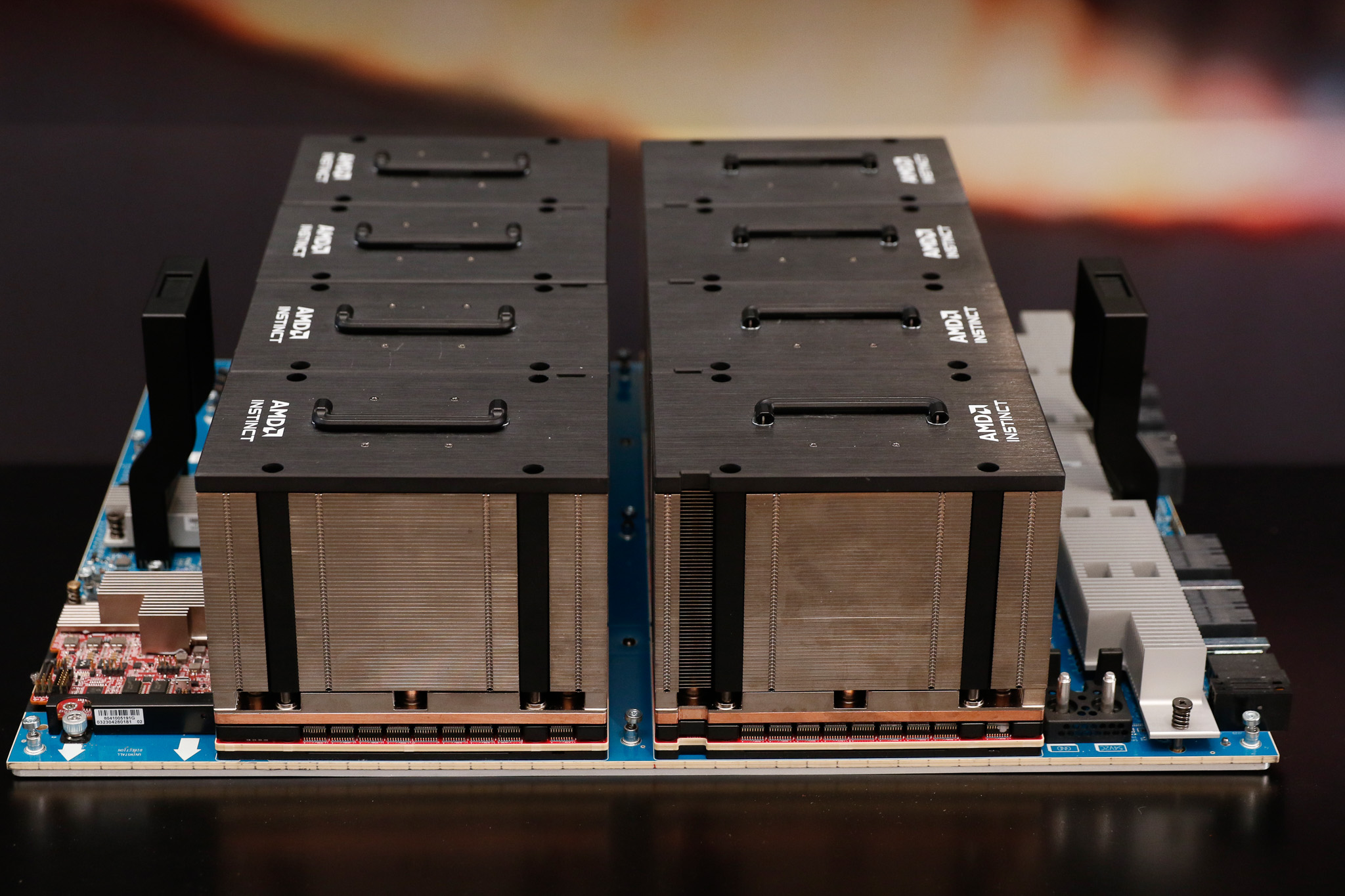

Egy szerdai befektetői rendezvényen az AMD fellebbentette a fátylat új adatközponti gyorsítóiról, az AI-modellek feltanítására optimalizált AMD Instinct MI300X-ről és az Instinct MI300A APU-ról, melyek elődjeikhez képest az iparági trendeknek megfelelően nagyobb számítási teljesítményt nyújtanak energiahatékonyabb működés mellett.

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

Az AMD CDNA 3 architektúrára épülő MI300X a HBM3 memóriakezelésnek köszönhetően a közvetlen elődnek számító MI250X-hez képest másfélszer annyi memóriát képes kezelni, memória-sávszélessége pedig 1,7-szeresére nőtt (a gyakorlatban ez 192 GB maximális memóriakapacitást és 5,3 TB/s sávszélességet takar). Ezzel az MI300X memóriakezelése és memóriasávszélessége nem csak a kurrens Nvidia H100-as gyorsítót előzi meg, hanem a november közepén bejelentett, csak jövőre érkező H200-at is.

Az AMD Instinct Platformmal a cég platformszintű megoldást is kínál a megrendelőknek, mely hasonlóan épül fel, mint az Nvidia H100 HGX - a nyolc MI300X processzort integráló platform 1,5 TB memóriát kezel.

A processzorgyártó most bemutatott megoldásaira a nagyobb adatközpont-üzemeltetők és iparági szereplők szinte kivétel nélkül leadták már megrendeléseiket, így az MI300X és MI300A processzorokat egyaránt használja majd a Meta, a Microsoft, az Oracle és az OpenAI is a saját adatközpontjaiban.

A gyártó egyelőre ugyanakkor eladásokban még nem fogja az Nvidia-t utolérni, a cég legalábbis jövőre összesen mintegy kétmilliárd dollárnyi árbevétellel számol az adatközponti termékek piacán, míg az Nvidia csak a legutóbbi negyedévben 14 milliárd dollár értékben értékesített ilyen megoldásokat (igaz, ez nem kizárólag az AI gyorsítókból származott).

A siker egyik kulcsa a termékek árazása lehet, melyről az AMD nem árult el semmilyen konkrétumot a szerdai rendezvényen, azt leszámítva, hogy az újdonságok olcsóbbak lesznek, mint az Nvidia megoldásai (egyetlen H100-as chip jelenleg körülbelül 40 ezer dollárba kerül).