Régi adósságot törleszt az Nvidia az új MI-célprocesszorral

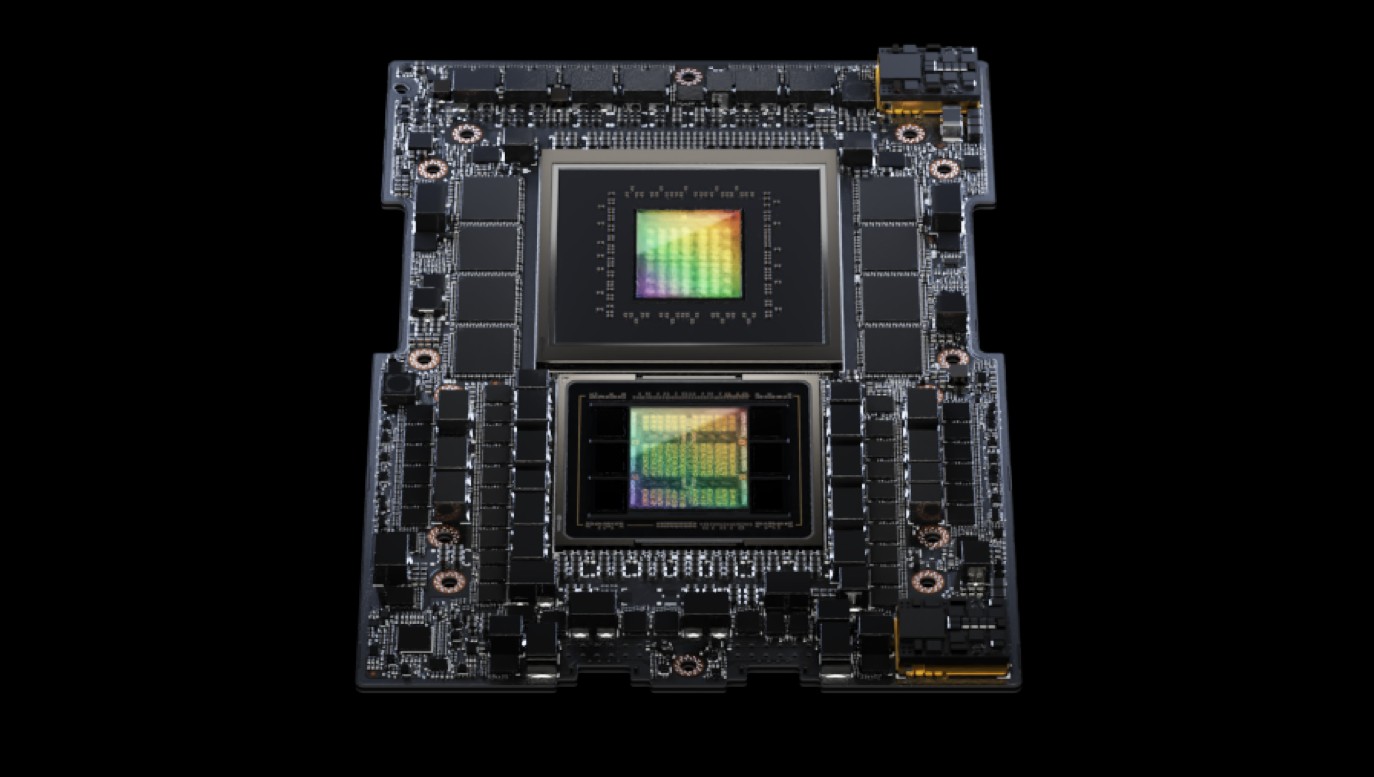

Bejelentette vadonatúj, generatív MI-modelleket kiszolgáló számítási platformját a szegmens szinte egyeduralkodónak tekinthető szereplője, az Nvidia. A jövőre érkező HBM3e-kompatibilis GH200 Grace Hopper platform elődjeinek egy komoly hiányosságát fogja orvosolni.

Ismét magasabbra teszi a lécet az MI-számításokra kihegyezett, brutális teljesítményű célprocesszorokat illetően az Nvidia, melynek Grace Hopper platformja a szegmens szinte egyeduralkodójának tekinthető. A HBM3e-kompatibilis GH200 platform ráadásul ott javul jelentősen, ahol elődjeit a legtöbb bírálat érte: a memóriakezelés, memóriasávszélesség terén, mely korábban gyeplőként visszarántotta az egész rendszer teljesítményét.

Az elődjeihez hasonlóan számos konfigurációban készülő GH200 kétchipes alapkonfigurációja a HBM3e-memóriakezelésnek köszönhetően közvetlen elődjéhez, a jelenleg elérhető H100-hoz képest a megnövelt memóriakapacitásnak köszönhetően jelentősen nagyobb (a gyártó szerint akár 3,5-szer nagyobb) modellekkel képes dolgozni, miközben a kombinált memóriasávszélesség a háromszorosára, 10TB/sec-re nőhet.

Introvertáltak az IT-ban: a hard skill nem elég Már nem elég zárkózott zseninek lenni, aki egyedül old meg problémákat. Az 53. kraftie adásban az introverzióról beszélgettünk.

A Grace Hopper GH200 további teljesítményadatait egyelőre nem közölte a gyártó, az architektúra azonban a drasztikusan javuló memóriakezelést leszámítva látszólag nem tartalmaz semmilyen komolyabb fejlesztést, így változatlan marad a PCIe Gen 5 támogatás és az NVLink, mellyel legfeljebb 256 darab GH200 processzor köthető össze egy gigantikus teljesítményű MI-szuperszámítógépben.

Az új rendszerek szállítása valamikor a jövő év második negyedévében, hogy pontosan mennyiért, arról egyelőre szemérmesen hallgat az Nvidia. Az elődmodell H100 árából kiindulva a dollárosított egységnyi teljesítmény aligha fog javulni: 1 db H100-as chipet tartalmazó gyorsítókártya jelenleg nagyjából 40 ezer dollárba kerül.

A cég első számú vevői többnyire a nagy felhőszolgáltatók, illetve a generatív nyelvi modelleket működtető cégek, köztük az Alphabettel (Google), Microsofttal és az AWS-sel.