Bemutatkozott az Nvidia első Ampere alapú GPU-ja

Az adatközpontokba szánt A100 elődjéhez képest akár hússzoros teljesítménynövekedést ígér.

A koronavírus járvány miatt online rendezte meg idei GTC konferenciáját az Nvidia, amelyen bemutatta első, Ampere architektúrára építő termékeit. A bejelentések élén az A100 GPU lovagol: vállalat szerint az adatközpontokba szánt A100 jelenti az eddigi legnagyobb generációs ugrást GPU-i történetében. A harmadik generációs tensor magokkal dolgozó eszköz hússzoros gyorsaságnövekedést ígér a Volta alapú megoldásokhoz képest, ami tekintélyes, 5 petaflops teljesítményt jelent.

A TSMC 7 nanométeres gyártási eljárásával készült A100 tiszteletet parancsoló, 54 milliárd tranzisztort tartalmaz, két és félszer annyit, mint elődje, a V100 - ezeknek egy méretes, 826 négyzetmilliméter alapterületű GPU lapka ad otthont. A memória-sávszélesség is komoly előrelépést mutat, összesen másodpercenkénti 1,6 terabájtot produkál. Az izmosabb teljesítmény persze számottevően nagyobb fogyasztást jelent, az A100 az előd 350 wattos maximumát 400 wattra emeli.

Az A100 többféle, precíziós betanítási formátumot is támogat különböző gépi tanulási folyamatokhoz, illetve alacsonyabb precizitású formátumokat a következtetésekhez (inferences), így AI munkafolyamatok széles skálájához bevethető. Az eszköz ráadásul jól skálázható, a gyorsítók a gyártó immár harmadik generációs NVLink megoldásával kapcsolhatók össze - emellett egy A100 erőforrásai párhuzamosan több feladatra is kioszthatók, a cég Multi-Instance GPU technológiájával. Utóbbival az eszköz akár 7 virtuális GPU-ra választható szét, amelyek mind dedikált SM, L2 cache és memóriavezérlő-allokációt kapnak.

USA Tech Hub: ahonnan a passzátszél fúj Minden, ami a technológiai szektorban történik, jellemzően az USA-ból indul.

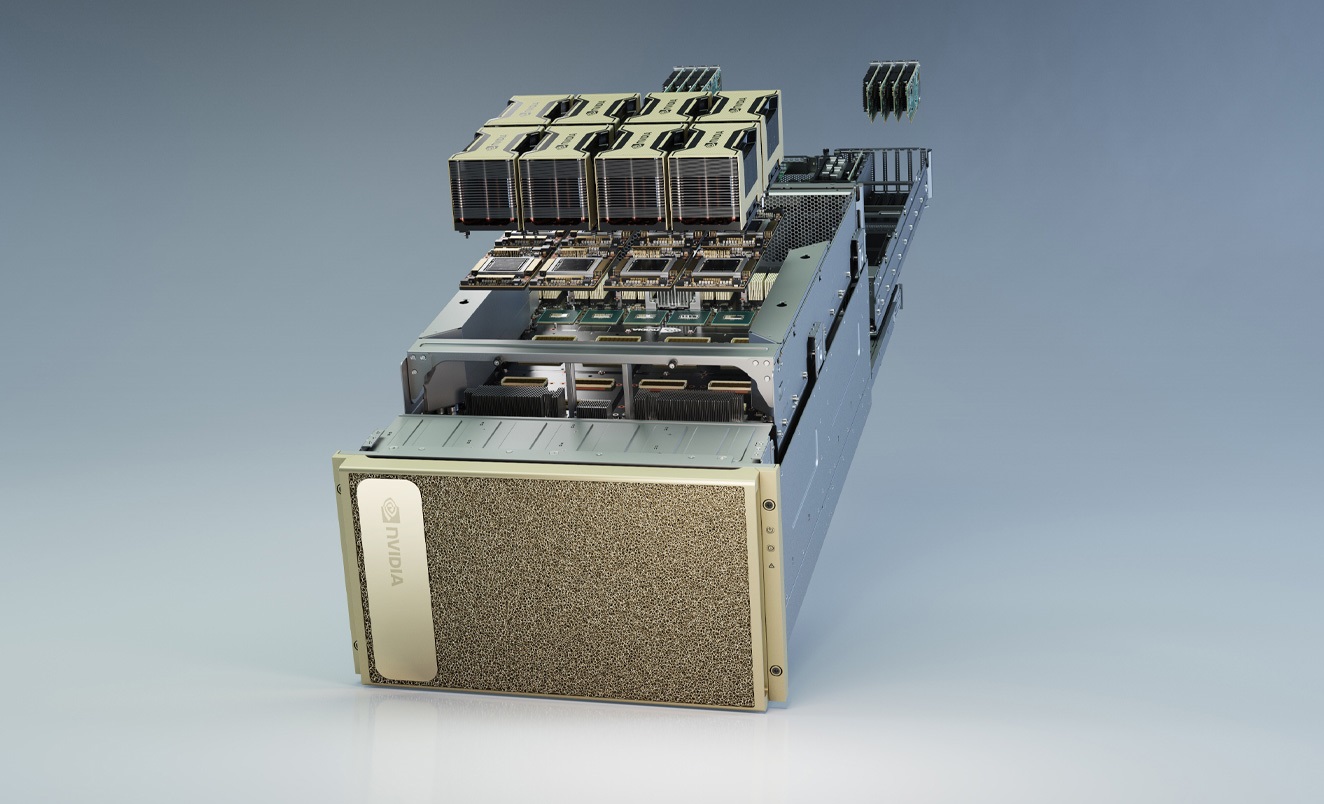

Az új GPU gyártása már gőzerővel zajlik, illetve az első darabok leszállítását is megkezdte az Nvidia, új, DGX A100 szervereinek részeként. A DGX100 összesen nyolc A100 gyorsítót tartalmaz, 15 terabájt tárterület, két AMD Rome 7742 CPU, 1 terabájt RAM és Mellanox vezérlőkre építő HDR InfiniBand interconnect társaságában. A DGX A100 vaskos, 199 ezer dolláros árcédulával vásárolható meg.

Az Nvidia a szerverekre építve mindjárt egy méretes klasztert is leleplezett, a DGX SuperPod formájában: ez 140 darab DGX A100 rendszerből áll, amelyek összesen mintegy 700 petaflops teljesítményt produkálnak. A SuperPod összeállítása a cég szerint alig három hetet vett igénybe, azt a vállalat többek között az önvezető autós AI kutatásokhoz használja majd. A SuperPodról az Nvidia egy referenciadizájnt is közzétett. Az A100-ra már most egy sor felhős nagyvállalat lecsapott, az AWS, a Cisco, a Dell, a Google, a Microsoft, az Oracle, a HPE, illetve az Alibaba és a Baidu is megkezdte annak beépítését saját adatközpontjaiba