Kincset érő adatokkal frissül a gépi tanuláshoz szánt Open Images

A Google neurális hálók betanítását célzó, gigászi képadatbázis hatodik verziójához érkezett.

A gépi látással foglalkozó kutatók örömére befutott a Google által kezelt Open Images V6-os verziója, amely jócskán kiterjeszti a datasetben tárolt képekhez kapcsolódó annotációk tárházát - azok között így már egyebek mellett különböző új vizuális kapcsolatok és emberi tevékenységek is ott vannak, illetve egy új, címketípust is bevezet.

A 2016-ban rajtolt Open Images a jelenleg elérhető legnagyobb, a neurális hálók betanításához használt, felcímkézett ingyenesen hozzáférhető képadatbázis, amelyet a fejlesztők jellemzően gépi látási feladatokhoz vetnek be. A Google által összeállított adathalom 5. kiadása tavaly májusban látott napvilágot, és összesen mintegy 9 millió képet tartalmazott, több mint 36 millió képszintű címkével, 15,8 millió objektumbehatároló dobozzal és 391 ezer feltüntetett vizuális kapcsolattal.

MONDJA ÉS MUTATJA

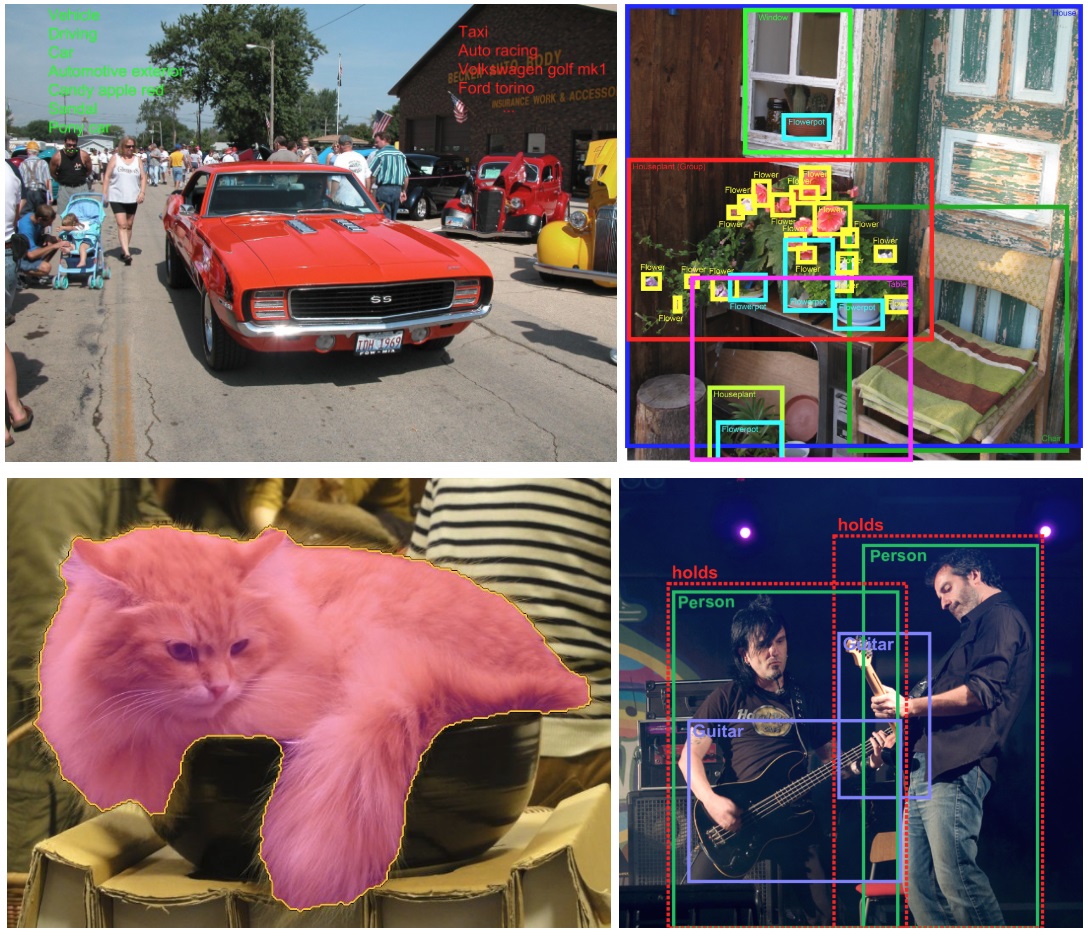

A V6-os kiadás egyik nagy újítása a lokalizált narratívák bevezetése. Ezek teljesen új, információgazdag, összefüggő szöveget, hanganyagot és vizuális segédletet is tartalmazó annotációk, amelyek az Open Images képtárából már 500 ezer képhez érhetők el. A lokalizált narratíváknál egy-egy képnél a címkézők élő beszéddel írják le annak tartalmát, miközben az éppen tárgyalt részleteket a képen a kurzorral jelölik. A képekhez a leírás szövege, illetve hanganyaga is elérhető, valamint a kurzor mozgása is követhető a narráció közben. A beszélt szöveget a címkézők maguk gépelik le, kerülendő az automatikus átiratok esetleges hibáit - ugyanakkor a Google azért utóbbiakat is elkészíti a felvételekről, hogy azok időbélyegeihez pontosan szinkronizálhassa mind a felmondott szöveget, mind a feliratokat és az egér mozgását.

Az újfajta, multimodális annotációtípust a Google azért hozta létre, hogy könnyebben tanulmányozható legyen a látott tartalmak és a nyelv kapcsolata. Erre bizonyos szintig a képek hagyományos címkézése, illetve azokról egyszerű, szöveges leírások készítése is alkalmas, ennek ugyanakkor több korlátja is akad - bizonyos esetekben kétséges lehet, például hogy a leírás adott része a kép mely területére vonatkozik. Ez a képekre húzott, a címkékhez csatolt objektumjelölő dobozokkal valamelyest kiküszöbölhető, az új módszer viszont a kurzormozgással az összefüggő szöveg minden egyes szavánál egyértelművé teszi, hogy az a kép pontosan melyik részére vonatkozik.

Localized Narratives Example

Még több videóUSA Tech Hub: ahonnan a passzátszél fúj Minden, ami a technológiai szektorban történik, jellemzően az USA-ból indul.

A frissen bevezetett címketípus a vállat szerint új kutatási területeket is megnyithat, annak vizsgálatára, hogy az emberek pontosan hogy is írják le az egyes képeket - ez a későbbiekben egy sor hasznos adatot biztosíthat a különböző UI és UX tervezési munkák során is. Érdekesség, hogy a lokalizált narratívák elkészítése során a címkézők kurzorai összesen mintegy 6400 kilométert tettek meg, a hangfelvételek összesített hossza pedig közel másfél év.

Mindezek mellett a frissített kiadásban jóval több vizuális kapcsolattípus tűnik fel: többek között már olyan címkékkel is találkozhatunk mint "gördeszkázó férfi", vagy "egymás kezét fogó férfi és nő". Az új kiadás emellett az emberi tevékenységek felcímkézésére is ráfeküdt, az "ugrás", "mosolygás" vagy "fekvés" és hasonló címkékből már mintegy 2,5 millió található meg az adatbázisban. A pakk nem kevesebb mint 23,5 millió új, emberek által ellenőrzött képszintű címkével is kiegészül, így azokból összesen már 59,9 milliót tartalmaz, mintegy 20 ezer kategóriában.