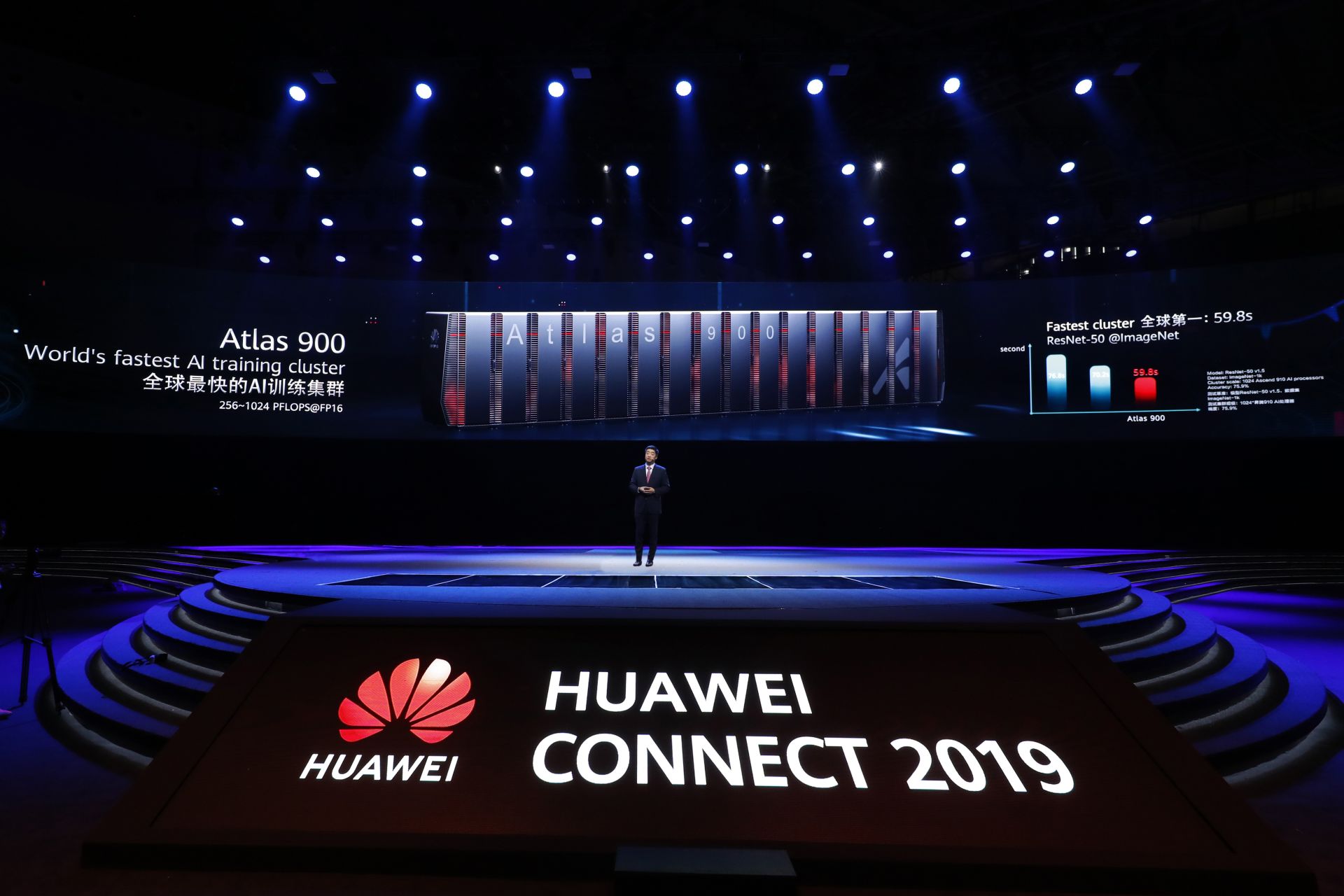

Rekordgyors a Huawei gépi tanulásos klasztere

Bemutatta gépi tanulásos tréninghez fejlesztett klaszterét a Huawei, amely mind számítási teljesítményben, mind pedig hatékonyságba felüllicitálja a konkurenseket.

A kínai vállalat állítja, az Atlas 900-ra keresztelt megoldás felülmúlja a közvetlen konkurensek teljesítményét, amely egyben rekordot is jelent a jelenlegi piacon. A Huawei klaszterének érdekesség, hogy nem csak az építőkockákat jelentő szerverek, de az azokban található gyorsítók is házon belül készültek. A vállalat további bejelentése szerint a Atlas 900 rendkívül magas számítási kapacitása a felhőben is elérhető lesz a Huawei Cloud EI Cluster szolgáltatással.

Az Atlas 900 az augusztus végén bejelentett Ascend 910 gépi tanulásos gyorsítóra épít. A chip az Ascend-Max széria legerősebb tagja, melynek alapját az ugyancsak saját tervezésű DaVinci Max mag jelenti, amelyből összesen 32 darab került az Ascend 910-be. A végrehajtóegységeket háló topológiával (mesh) kapcsolták össze a tervezők, működésüket pedig 32 megabájt megosztott gyorsítótár segíti. A magok mellé fixfunkciós dekódolók is kerülteket, melyek segítségével valós időben dolgozható fel 128 különálló videócsatorna adatfolyama, amely például különféle megfigyelőrendszereknél jöhet kapóra. A lapkában található memóriavezérlőhöz négy darab HBM 2-es memória kapcsolódik. Az aggregált sávszélesség másodpercenként 1,2 terabájt, amely aranyat érhet a jellemzően memóriaigényes gépi tanulásos tréningnél.

Az Ascend 910 félpontosságú lebegőpontos műveleteknél (FP16) 256 TFLOPS-os, INT8 (8 bites integer) műveleteknél pedig 512 TOPS a csúcs. Ezek nagyon magas értékek, a Tesla V100-as gyorsítója ugyanis FP16 esetében 31,4 TFLOPS-ra, INT8-nál pedig 125 TOPS-ra képes. A specifikációk alapján tehát félpontosságú lebegőpontos műveleteknél az Ascend 910 közel kilencszer gyorsabb az Tesla V100-nál, miközben a Huawei fejlesztésének TDP-je csupán 40 százalékkal magasabb. Az Nvidia GV100-as chip jelentős hátrányának egyik oka a klasszikus GPU-s felépítés, hisz míg az Ascend 910-et már célzottan gépi tanulásos műveletekre hegyezték ki, addig az Nvidia lapkája grafikus megjelenítésre is képes. Szintén a Huawei oldalára billenti a mérleget a fejlettebb, 7 nanométeres gyártástechnológia, amelyre az Nvidia csak a következő évben tér át.

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

Az Ascend 910-ből összesen 8 darab fér el egyetlen, vízhűtéses node-ban két darab Intel Xeon processzorral karöltve, amely így legfeljebb 2 PFLOPS számítási kapacitást nyújthat 6000 wattos maximális disszipáció mellett. A Huawei ezeket rendezte klaszterbe, melynek teljesítménye 256 és 1024 PFLOPS között skálázódhat, amely 128-512 darab node-ot feltételez. A gyártó szerint a maximális kiépítés mellett a jól ismert ResNet-50 modellt alkalmazva Imagenet-1k dataset mellett 59,8 másodperc alatt végzett a tréningezéssel az Atlas 900, amely közel 15 százalékkal kevesebb idő, mint amire a finom anonimitásba burkolt második helyezettnek (Nvidia DGX Superpod?) volt szüksége.

Felhőben is

Az Atlas 900 számítási kapacitásának eléréséhez nem feltétlenül szükséges megvásárolni a Huawei-től (és üzemeltetni) a vélhetően igencsak költséges klasztert, az a cég publikus felhőjének hála a Huawei Cloud-ból is elérhető lesz, egyelőre csak az APAC régió egyes országaiban. A vállalat ígéri, az EI Cluster Service a kimagasló számítási teljesítmény mellett rugalmas konfigurálhatóságot nyújt majd, amelyre építve jóformán bármilyen gépi tanulásos modell futtatható lesz. A pay-per-use modellben működő szolgáltatás árazásáról egyelőre nem beszélt a Huawei, az elhangzottak alapján azonban ilyen szempontból is versenyképes lehet majd az EI Cluster Service, amit egyetemek és kutatóintézetek jelentős kedvezménnyel vehetnek majd igénybe.