Küszöbön a TensorFlow 2.0 alfa verziója

A Google gépi tanulási keretrendszere beágyazott rendszerekre szabott verziót is kap.

Több újdonsággal is készült a Google idei TensorFlow fejlesztői konferenciájára: a keresőóriás a rendezvényen egyebek mellett a gépi tanulási keretrendszer 2.0-s verziójának alfa kiadását is leleplezte, továbbá mobil- és beágyazott eszközökre szánt verzió és dedikált fejlesztői hardver is akadt a bejelentések között.

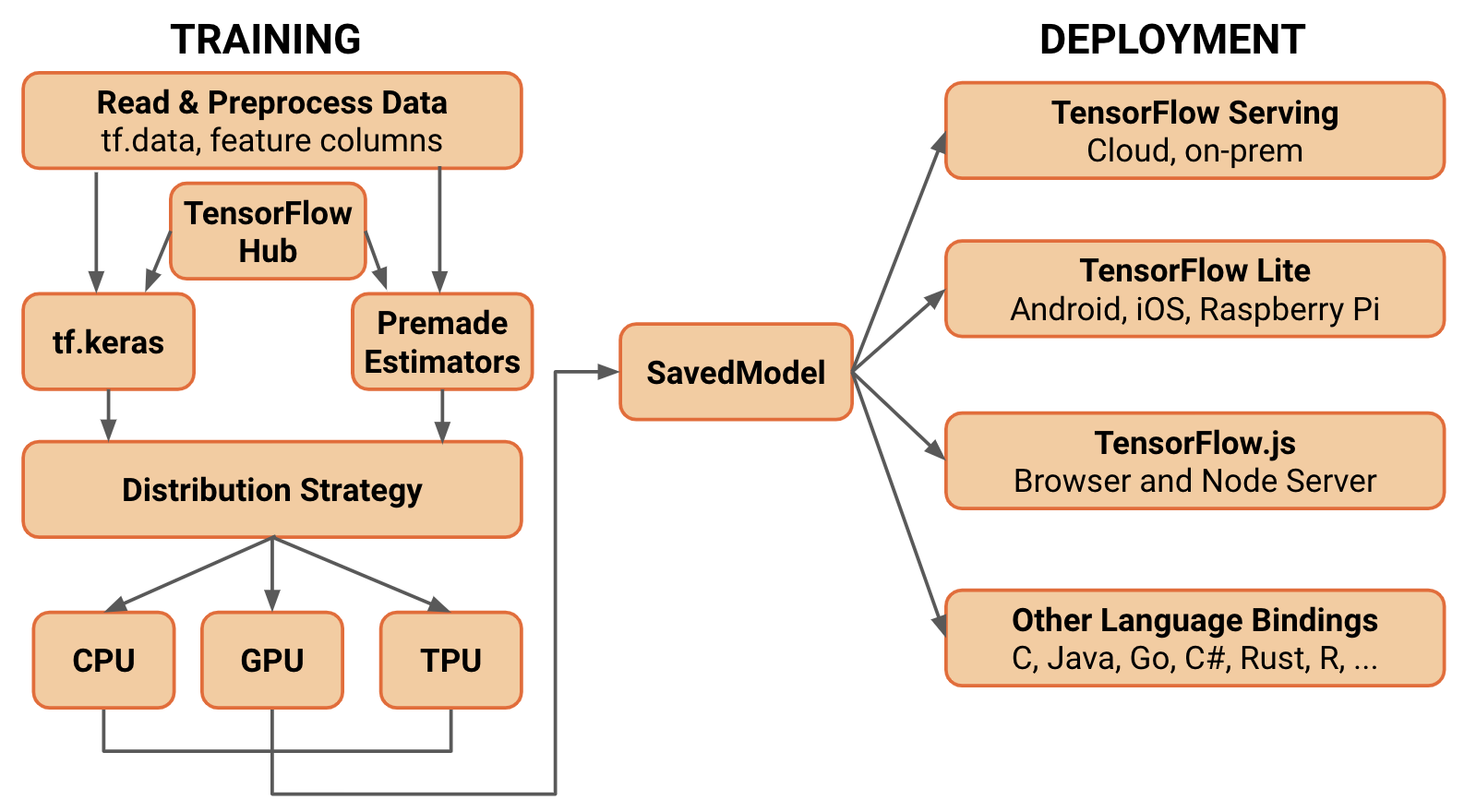

Az új főverzióval a vállalat az egyszerű kezelésre törekszik, hogy az a gépi tanulás területével ismerkedők számára is könnyen használható legyen. Ennek érdekében a vállalat nyílt forrású, Pythonban íródott Keras API-val teszi lehetővé a deep learning modellek betanítását - egy sor elavult, illetve redundás API-t pedig kigyomlál a keretrendszerből, beleértve a Slim és a Layers API-kat is. Mindezek mellett a tavaly bevezetett Eager Execution programozási környezet is előtérbe kerül, amelyben azonnal elvégezhető az egyes műveletek értékelése, külön gráfépítés nélkül. Az Eager Execution a TensorFlow 2.0-ban már alapértelmezett platformmá válik.

Az alfa verzióban a fejlesztők már kipróbálhatják az új API-kat, illetve elkezdhetik igazítani saját megoldásaikat az átszabott keretrendszerhez. A Google ebben is segít, több konverziós, illetve migrációs eszközt is elérhetővé tesz, továbbá részletes dokumentációval is igyekszik támogatni az átállást a rendszer első főverziójáról 2.0-ra.

Az IoT-nak is jut az AI-ból

A konferenciána TensorFlow Lite 1.0-ról is lehullt a lepel, a keretrendszer "kikönnyített" verzióját a Google kifejezetten a korlátozott erőforrásokkal dolgozó, IoT, beágyazott, illetve mobileszközökre szánja. A megoldásról először a 2017-es Google I/O fejlesztői konferencián hallhattunk, azóta pedig előnézeti verzióban volt elérhető.

A keretrendszerben a Google szelektív regisztrációs, illetve kvantizációs technikákat vet be a gépi tanulási modellek betanítása során, valamint azt követően, amivel gyorsabb és kisebb végeredményt ígér - a Venturebeat szerint a megoldással akár negyedére is csökkenhet egyes modellek mérete. A keretrendszert célzó modellek betanítása a teljes értékű TensorFlow-ban kezdődik, majd ezután konvertálható a Lite verzióba, és juttatható el a mobil-, illetve beágyazott eszközökre.

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

A keretrendszer fejlesztőcsapata a jövőben még hatékonyabb modellgyorsítást ígér, elsősorban a neurális hálókkal dolgozó Android fejlesztők számára, de a CPU-s teljesítményoptimalizáción is dolgoznak, amelyhez más vállalatokat is terveznek partnerként bevonni. A TensorFlow Lite-ot már most egy sor natív Google-alkalmazás használja, mint a GBoard, a Google Photos, a Nest és az AutoML - de a Google Assistant által az offline válaszadáskor használt CPU modellek is a Lite-ra támaszkodnak. Az új keretrendszer az androidos készülékeken túl Raspberry Pi-n is kipróbálható - illetve a Google ugyancsak frissen bejelentett, Coral Dev Board névre hallgató eszközén is igába hajtható.

A Coral Dev Board egy első pillantásra a Raspberry Pi-re emlékeztető fejlesztői lapka, amelyen egy NXP iMX8M SoC, illetve egy Edge TPU (Tensor Processing Unit) is dolgozik, kifejezetten gépi tanulási folyamatokra kihegyezve. A céleszközt a Google különböző prototípus-készítési feladatokra szánja, mint például a gépi látásra támaszkodó alkalmazások - ehhez egy kameramodult is elérhetővé tesz a Coral Dev Boardhoz. A 150 dollárért kapható lapka mellett a cég egy USB-s gyorsítót is piacra dob: a 75 dolláros Coral USB Acceleratorral lényegében bármilyen Linux rendszer megtoldható egy Edge TPU-val, USB 2.0 vagy 3.0 kapcsolaton keresztül, beleértve a Raspberry Pi lapkákat is. A cég későbbiekben PCIe csatolós variánst is ígér a gyorsítóból. A keresőóriás TensorFlow fejlesztői konferenciájának teljes tartalmáért érdemes felkeresni a Google kapcsolódó blogposztját.