Már saját gyorsítója is van Google-nak

Saját gyorsítót jelentett be a Google, a TPU elnevezésű egység óriási lökést adott a vállalat gépi tanulásos rendszerének, amiben már több mint egy éve alkalmazzák élesben a fejlesztést.

Először pedzegette egyedi, saját fejlesztésű gyorsítóját a Google, a vállalat az I/O fejlesztői konferenciáján jelentette be, hogy már több mint egy éve használja a TPU (tensor processing unit) gyűjtőnevű fejlesztést. A Google szerint a saját igényekhez igazított chipje óriási előrelépést jelentett a hatékonyság növelésében, a hivatalos bejegyzés "hét éves ugrásról beszél", vagyis Moore törvénye alapján ennyi időbe kerülne elérni a mintegy tízszeres teljesítmény/fogyasztás javulást.

A TPU névre keresztelt egyedi ASIC részleteiről sajnos nem árult el túl sokat a Google, sem a cég kutatóinak tudományos publikációiban, sem más forrásokban nem leltünk az architektúra nyomára. Annyi bizonyos, hogy nem könnyen újrahuzalozható FPGA-ról, hanem ASIC-ról, azaz alkalmazás specifikus áramkörről van szó, amely a cég (immár szabad szoftveres) TensorFlow gépi tanulásos algoritmusának egyedi függvényeit képes nagyságrendekkel gyorsítani.

A Google elejtette, hogy a lapka kimondottan az alacsony pontosságú lebegőpontos számításokhoz készült, ebben a hagyományos x86-os processzorokhoz képest lényegesen gyorsabb tud lenni, miközben alacsony fogyasztással és kevesebb tranzisztorral dolgozik. A vállalat állítása szerint a lapka kézhezvételétől számított 22 napot követően már adatközpontjaiban működtek a TPU-k, tehát az implementáció villámgyorsan lezajlott.

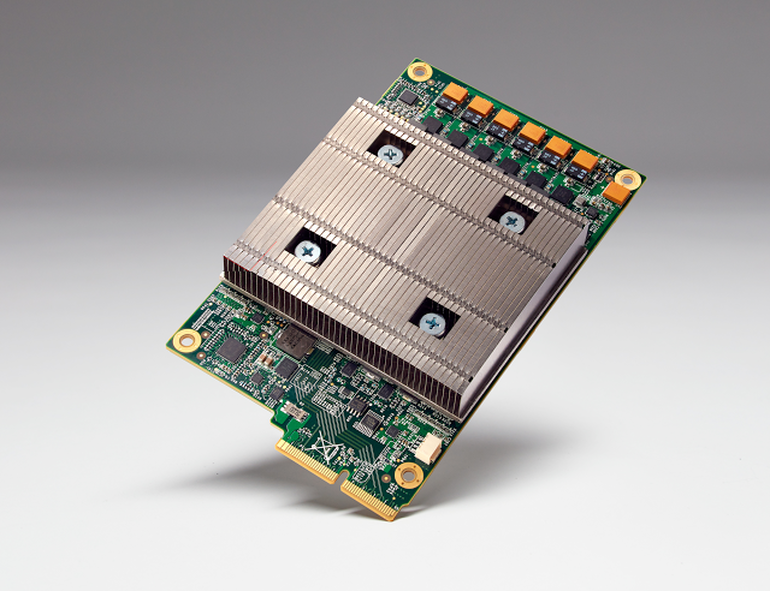

Maga a TPU egy kisméretű nyomtatott áramkörön kapott helyet, melyen a tápellátás mellett egy kisebb méretű hűtőborda látható. A teljes modul méretét ugyan nem közölte a Google, de elmondásuk szerint az egységek az adatközpontokban használt rackek merevlemez slotjaiban laknak, ami relatíve kis területet jelent.

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

Az elmúlt bő egy év során már több területen is bevetették a gyorsítók számítási kapacitását, a RankBrain mellett a Maps és a Street View pontosságát és minőségét is javíthatták már a TPU-k. Emellett a vállalat AlphaGo számítógépét is megspékelte az egyedi chipekkel, mely többek között a gobajnok, Lee Sedol idei legyőzéséhez is hozzájárult.

Nem ez az első, és nem is az utolsó

Nem ez a Google első szilíciumos próbálkozása. A keresőóriás legutóbb egy egzotikus hálózati chippel került be a hírekbe, a Lanai nevű processzor februárban bukkant fel a LLVM nyílt forrású fordítóhoz készült patch-ben. A mostani bejelentés tehát csak tovább erősíti a már korábban kirajzolódott trendet, miszerint az adatközponti rendszerek világa egyre inkább és egyre gyorsabban tolódik el az egyedi fejlesztésű chipek irányába, az általános célú processzorok lassú fejlődése egyre kevésbé képes kiszolgálni a rohamléptékben növekvő igényeket.

Hasonló irányú próbálkozásai már mind a Facebooknak, mind a Microsoftnak is voltak, utóbbi vállalatról már lassan két éve tudhatjuk, hogy FPGA-kkal kísérletezik, az ilyen újraprogramozható chipek használatával sikerült megduplázni a Bing teljesítményét. Ugyancsak ide kapcsolódik az Intel tavalyi, 16,7 milliárdos felvásárlása, mellyel megszerezte az FPGA-gyártó Alterát, és terméktervbe vette a Xeon-FPGA kombinált processzorokat, amelyek kimondottan az ilyen feladatkörbe illeszkednek majd.