SSD-gyilkos technológiát mutatott az Intel és a Micron

Már 2016-ban sorozatgyártásba kerül az Intel és a Micron által fejlesztett, vadonatúj rezisztív memória-technológia, a 3D XPoint. A két cég ígérete szerint a DRAM és a NAND közé illeszkedő új tároló alapjaiban rázhatja fel a megszokott memória-hierarchiát, hatása jelenleg felmérhetetlen.

Vadonatúj félvezető-alapú tárolótechnológiát jelentett be a tegnap este az Intel és a Micron, ezzel el is lopta a Windows 10 elől a nap híre titulust. A 3D XPoint (ejtsd: 3D Crosspoint) a két cég ígérete szerint a NAND-nál (flash-nél) nagyságrendekkel gyorsabb és tartósabb, azonban megfizethető alternatíva, amely forradalmasítani fogja a PC-k mellett a nagyvállalati rendszerek világát is.

You had my curiosity, now you have my attention

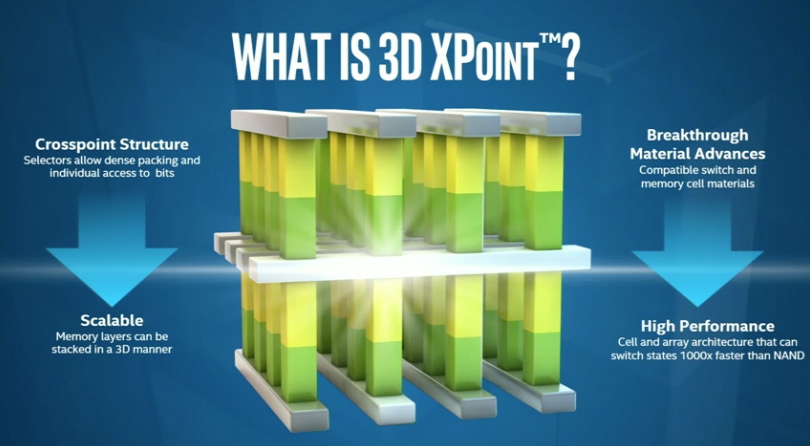

A bejelentés csupán a technológia felszínét kapargatja, de már így is rengeteg újdonságot mutatott meg a két cég. A rendelkezésre álló információk alapján az XPoint vadonatúj anyagokat és vadonatúj gyártástechnológiát használ. A csattanó: az XPoint felépítésében nincsenek tranzisztorok, a különleges, egymást térben keresztező "csövek" a csomópontokon tárolják az információt. Az Intel szerint a tárolt bitek akár egyenként is elérhetőek, ha ez valóban így van, az hatalmas áttörés, a DRAM ugyanis soronként éri el az adatokat, a NAND pedig szintén problémás, cellánkénti elérést alkalmaz, e korlátok megkerülése komoly erőfeszítéseket igényel a vezérlő fejlesztőjétől és a teljesítményt is visszaveti.

Ahogy említettük, a flash-től eltérően az XPoint nem tranzisztorokban tárolja a biteket, ehelyett egy hosszú évek óta fejlődő technológiát, úgynevezett rezisztív tárolást használ. Ilyenről már hallottunk korábban, 2013-ban például a Crossbar jelentette be RRAM névre keresztelt megoldását, amely wolfram és ezüst rétegek közötti amorf szilíciumot használt tárolásra. Az Intel-Micron megoldásban használt anyagokról egyelőre nincs hír, a tárolás azonban jó eséllyel hasonló elven működik - erre utal például az is, hogy a XPoint az RRAM-hoz hasonlóan bitenként írható-olvasható.

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

Nyilvános információ az is, hogy az XPoint rétegezhető technológia, vagyis a 3D NAND-hoz hasonlóan ez is több rétegben egymásra helyezhető (nyilván innen a 3D XPoint elnevezés). Ez azt jelenti, hogy a kapacitássűrűség szinte tetszőlegesen skálázható, 4-8-16-32 vagy akár sokkal több réteg is egymásra helyezhető lehet. Ez fontos lesz a technológia jövőjét illetően, a miniatürizálás (a struktúrák kicsinyítése) mellett ez a nagy kapacitású chipek gyártásának kulcsa. Van egy másik alternatíva is, a NAND-hoz hasonlóan a több bit tárolására képes cellák kifejlesztése - ez azonban egyelőre csak tervekben szerepel.

Memória-hierarchia: betömni a rést

A számítógépekben és az okostelefonokban is több évtizede azonos sablon szerint rendezzük hierarchiába az adattárolást. A leggyorsabb szinteken a (ma már) processzorra integrált gyorsítótárak vannak, ezt követi az operatív tár (RAM). Ezek a szintek volatilis technológiát használnak, vagyis folyamatos frissítést igényelnek, feszültség hiányában az ezeken tárolt adat végleg elvész. A következő szintet adja a háttértár, az SSD-k és HDD-k tartoznak ide, ez már nem-volatilis (nem felejtő), vagyis a gép teljesen kikapcsolt állapotában is hosszú távon képes megőrizni az adatokat. A hierarchia lefelé egészen messzire nyújtható, a következő szint lehet például a hálózati tároló (NAS), azt követően pedig a szalagos tárolók következnének.

Sok nagyságrendű ugrás ott középen, a memória és a merevlemez között

De miért építünk ilyen hierarchiát, miért nem tárolunk minden adatot mondjuk a másodszintű gyorsítótárban? A probléma, hogy egyik oldalon a sebesség és a késleltetés, másik oldalon a fogyasztás és a kapacitás között kompromisszumot kell kötni. Vagyis minél nagyobb, annál lassabb, és minél gyorsabb, annál többet fogyaszt. Így praktikus a tárolást szintezni, a nagyon fontos adatokat nagyon gyors tárolóra, a ritkán szükséges bitek pedig mehetnek a lassabb szintekre.

A jelenlegi hierarchiával azonban van egy komoly probléma: nem folytonos. Az operatív tár és a háttértár között gigantikus, sok nagyságrendet átfogó rés tátong, amelyen a forgótányéros merevlemezek SSD-re cserélésével nagyjából egy nagyságrendet tudtunk faragni. De így is maradt rengeteg lépcső a modern RAM 10 nanoszekundumos és a leggyorsabb SSD-k mintegy 100 mikromásodperces elérési ideje között. Ez azt jelenti, hogy nagyjából 10^-8 és 10^-4 másodperces nagyságrendű késleltetés között nincs rendelkezésre álló technológiánk.

A fenti mondat rengeteg dolgot megmagyaráz a PC-k felépítéséből. Az egyik a túlméretezett RAM. Mivel a következő szint sokszorosan lassabb, a számítógépeket úgy kell megépítenünk, hogy minden, amire a processzornak azonnal szüksége lehet, beleférjen az operatív tárba, ez indokolja, hogy már okostelefonok esetében is 4 gigabájtnyi RAM-ot mellékelünk a csúcsmodellekhez, a PC-s oldalon pedig a 4 gigabájt a minimumnak számít, a 8 gigabájt az alap, a felső határ pedig ennek két-négyszerese.

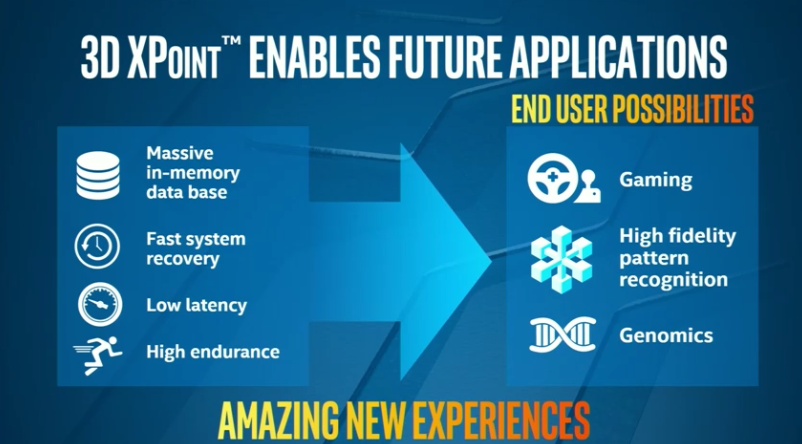

Oka van annak, hogy ezt a kitérőt beiktattuk, az XPoint legnagyobb hozadéka ugyanis az lehet, hogy ezt a rést az operatív tár és a háttértár között befoltozza. Az Intel ígérete szerint a technológia nagyságrendileg 100 nanoszekundumos, tehát 10^-7 nagyságrendű késleltetésre képes, ezzel tökéletesen illeszkedik a fent említett résbe. Ez a sebesség már elegendő ahhoz, hogy a RAM-ot tehermentesítse, a legtöbb itt tárolt adat ugyanis kényszerből és nem szükségből került erre a szintre (olyan, késleltetésre amúgy kevésbé érzékeny adatokra kell gondolni, amelyeknél a 10 vs 100 nanoszekundum nem szakítja meg a program futását). Ilyen kényszerre nagyvállalati környezetből ragyogó példát tudunk mondani, az in-memory adatbázisok létezését pontosan ez indokolja - az SSD túl lassú, így hiába drága és feleslegesen gyors a RAM, nincs jelenleg köztes lehetőség.

Új utakat nyit

Az tehát triviális, hogy például az in-memory adatbázisokat egy szinttel lejjebb, az XPoint-alapú tárolókra költöztethetjük, a hosszabb távú hozadékok azonban messze túlmutatnak ezen. A RAM tehermentesítésével ugyanis szükségtelenné válik a mai obszcén méretű memória fenntartása - adódik a lehetőség, hogy a memóriát a kapacitás helyett a magasabb integráció és a magasabb sebesség irányába fejlesszük. Igény, az lenne rá, a processzorra integrált grafika sebességét egyértelműen a RAM sebessége fogja vissza, de sok esetben a CPU-s teljesítményt is limitálja a sebességben (sávszélességben és késleltetésben is messze lemaradó) memória.

Hogy mire érdemes ezen a területen számítani, azt jól mutatja, hogy egyes gyártók már most is használnak eDRAM-ot (beágyazott memória), ilyen dolgozik szerveres környezetben a POWER 7 processzorok mellett, az Intel Iris Pro chipjeiben, vagy az Xbox One-ban is találunk ilyet. Azzal, hogy a RAM méretét töredékére vághatjuk vissza, megnyílik a lehetősége, hogy az közelebb kerüljön a processzorhoz, adott esetben megközelítve a méregdrága eDRAM sebességét, jóval magasabb kapacitás mellett, viszont jóval alacsonyabb áron.

Az XPointot természetesen a szoftveres fejlesztéseknek is le kell követniük, az operációs rendszereket és alkalmazásokat évtizedek óta a megszokott memória-hierarchiához írjuk, annak felborulását így valószínűleg némi csúszással fogja követni a szoftveres világ. Az XPoint pozitív hozadékai azonban olyan nagyok, hogy a kisebb-nagyobb szoftverházak várhatóan rövid időn belül rákényszerülnek, hogy beépítsék a támogatást rendszereikbe és alkalmazásaikba.

A szoftver mellett értelemszerűen szükség lesz a hardveres implementáció finomítására is, a jelenleg rendelkezésre álló adatbuszok, (memóriacsatornák, PCI Express, SATA, stb.) nem biztos, hogy ideálisak az XPoint szempontjából, így jó eséllyel készülhetünk egy új foglalat és egy új adatátviteli szabvány létrejöttére is.

Jövőre rajtol

Az Intel számára ennek reális üzleti hozadéka is lenne: a hagyományos DRAM- és NAND-gyártókat egy csapásra ki tudná szorítani a cég a számítógépekből. Az SSD-k helyére az új generációs XPoint tárolókat, a RAM helyére pedig adott esetben a processzorra integrált saját RAM kerülne, ezzel a PC félvezető tartalmának akár 70-80 százaléka is az Intel gyáraiból kerülne ki.

A hivatalos bejelentés szerint az Intel és a Micron is saját megoldásokat készít majd a technológiára alapozva. Az első termékek várhatóan SSD-k lesznek, tehát hagyományos (tippünk szerint PCIe vagy NVMe) csatlakozóval, hagyományos méretosztályban érkeznek, minden bizonnyal a piac legeslegtetejére pozicionálva, kihasználva a technológia sebességben élvezett előnyét.

A következő hullám érdekesebb lehet, a pletykák szerint memória-foglalatba illeszkedő XPoint-modulok jöhetnek, elsősorban az Intel szerveres platformjához illesztve. Ezzel gyakorlatilag a memória-alrendszer szintjén jönne létre storage tiering, a DRAM mellé szúrt XPoint modulokkal. A nagy fejtörést persze (ahogy fentebb említettük) a szoftveres támogatás jelenti, a "kétütemű" memóriát a Xeonok mellett nyilván az operációs rendszernek és az alkalmazásnak is támogatnia kell valamilyen formában.

Az XPoint megjelenésével a NAND-nak még messze nem fellegzett be, a flash jelenleg olyan árszinteken mozog, ahová az XPoint egyelőre nem tud (és valószínűleg nem akar) lejutni. Átfedés a legdrágább modellek esetében lehet, ott várhatóan az új technológia gyorsan kiszorítja majd a flash-meghajtókat, ez azonban leginkább az extrém igénybevételnek kitett adatközponti rendszereket érinti.

Az első modellekre nem kell már sokat várni, a bejelentés szerint az első termékek várhatóan 2016 elején jelennek meg a piacon. A gyártás beindulása azonban már nincs ennyire messze, a tesztüzem már most folyik, 2015 végére pedig az első, partnereknek küldendő mintapéldányok is elkészülnek majd.

A teljes bemutató itt tekinthető meg teljes hosszában: