Nem változtat stratégiáján az NVIDIA: irány a csúcs

Valószínűleg az elmúlt időszakban mutatott szenvedése magyarázza, hogy tőle szokatlan módon az NVIDIA középtávú termékterveket tett közzé, és hatalmas ugrásokat ígért teljesítményben. A cég nem váltott stratégiát, továbbra is a csúcsteljesítmény áll a fókuszban.

Bármi áron

Az NVIDIA néhány éve rálépett egy útra, amelynek a végén, ha egyáltalán van vége, az Intel trónjának átvétele áll. A vállalat ennek szellemében olyan irányt szabott ki az eredendően grafikus feladatokra szánt processzorai fejlesztéseinek, amellyel azok masszív kapacitásaikat és párhuzamosságukat megtartva egyre rugalmasabban alkalmazhatóak olyan számításigényes feladatokra is, amelyeket korábban az x86 vagy RISC processzorok végeztek.

Ennek érdekében az objektumorientált C programozási nyelv egy dialektusára alapozva az NVIDIA megalkotta a CUDA programozási felületet, a Fermi kódnevű fejlesztéssel pedig idén megjelent a natív sebességű, szabványos 64 bites pontosságú végrehajtás lehetősége az összes utasítástípusra, az utasításszálak közti gyors adatcserét lehetővé tévő osztott L2 cache, az adatkoherencia megtartásának részlegesen hardveres támogatása, és az ECC memória támogatása. A Fermi már sokkal kevésbé grafikus céleszköz, sokkal inkább egy általános célú számításokat végző, masszívan párhuzamos processzor, rugalmasan használható számítási erőforrásokkal.

Jogod van tudni: mankó kirúgáshoz, munkahelyi szkanderezéshez Ezúttal egy mindenki számára kötelező, de laza jogi különkiadással jelentkezünk. Ennyi a minimum, amit munkavállalóként illik tudnod.

Tudván, hogy egy valódi paradigmaváltáshoz legalább egy nagyságrendbeli teljesítménybeli előnyre kell szert tennie a számításintenzív alkalmazások nagy része alatt, mint amilyen a videokódolás, valósidejű vizualizáció, mérnöki és tudományos szimulációk, a Fermivel az NVIDIA a csúcsra tört. Az eredmény 529 négyzetmilliméter, nagyjából 3 milliárd integrált tranzisztor, 700 gigaflops feletti teljesítmény 64 bites pontosságú műveletekkel, akár 150 GBps memóriasávszélesség, és több mint 200 wattos fogyasztás.

Az NVIDIA azonban ezzel a manőverrel feláldozta versenyképességének nagy részét a grafikus chipek piacán, amely a legnagyobb bevételi forrása. A cég már tavaly ősszel, az új Radeonok megjelenésekor megkongatta a harangot, hogy tompítsa majd a Fermivel kapcsolatos várakozásokat, kijelentve, hogy nem számít, mi történik a videokártyák piacán. Az iparban terjedő pletykák szerint a már eredetileg is drágán termelhető Fermivel az NVIDIA-nak komoly gondjai akadtak az elektronikai implementáció és gyárthatóság során, aminek köszönhetően alacsonyabb órajeleket és a vártnál sokkal rosszabb selejthányadot mutatott. A Fermi-alapú GeForce-ok drágán és késve érkeztek, alacsony volumenben, és alulteljesítenek, aminek eredményeként az AMD hatalmas területet foglalt el. Az NVIDIA GeForce-eladásai közel harmadával zuhantak vissza a tavalyihoz képest.

Irány előre!

Irány előre!

Mindezek hatására sem tántorodott el az NVIDIA attól, hogy a Fermivel kijelölt úton tovább haladjon, a kaliforniai San Joseban a héten zajló technológiai konferencián a hangsúlyt továbbra is a szuperszámítógépes teljesítmény képezte. Jen-Hsun Huang elnök-vezérigazgató nyitóelőadásának sarokpontjai a korábban soha nem látott teljesítményre és programozásra épültek.

Huang bejelentette a CUDA-x86 projektet, amely lehetővé teszi a CUDA SDK környezetben létrehozott alkalmazások futtatását x86 processzorokon is, ezzel fokozva a CUDA vonzerejét a fejlesztők körében, növelve befektetésük megtérülését. Az ehhez szükséges fordítón a nagy teljesítményű számítástechnika világában jól ismert Portland Group (PGI) dolgozik, amely például uralja a terepet az Opteron/Linux párosításokban, ami a SPEC CPU2006 teszteket illeti. Huang ezt követően arról is beszélt, hogy a MATLAB eszközök támogatják majd a CUDA felületet klasztereken, amely az egyik legnépszerűbb programozási nyelv a kutatók és tudósok körében.

A további tűzijáték mellett, mint például a Fermivel gyorsított 3D Studio Max vagy Adobe Premiere Pro, tovább bővítik azt a japán szuperszámítógépet, amelyet két éve állítottak üzembe GPU-kkal felvértezve. A Tsubame 2.0 installációba 1056 darab Tesla S2050 rendszer kerül, amelyek összesen 4224 Fermi chippel mintegy 2 petaflops nyers számítási kapacitással bővítik a szuperszámítógép teljesítményét. A Tokiói Technológiai Intézetben üzemelő konfigurációt molekuláris biológiai kutatásokra használják majd decembertől, összteljesítménye várhatóan meghaladja a 3 petaflopsot.

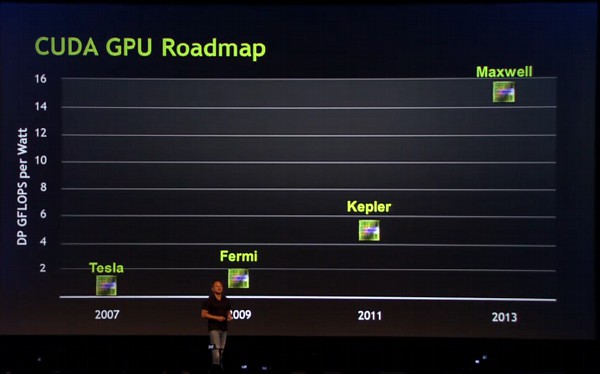

Huang ezt követően a jövőről beszélt, amelyben nem hogy lassítanának ezen az úton, hanem magasabb fokozatba kapcsolnak. A Fermi utódja, a Kepler a tervek szerint 2011-ben jelenik meg, és Huang ígérete szerint három-négyszeres teljesítményt hoz majd azonos fogyasztás mellett. Ehhez a fejlettebb gyártástechnológia mellett nagyban hozzájárul majd a megcélzott alkalmazások kódjainak elemzése alapján továbbfejlesztett mikroarchitektúra, valamint a tovább optimalizált fordítók is, tette hozzá Huang. A Keplert a Maxwell követi majd, amely egy újabb, hasonló ugrást jelent majd a cég elképelései szerint, és a Ferminél egy nagyságrenddel nagyobb teljesítményt képvisel majd, várhatóan 2013-ban - igaz, ha a Fermit vesszük alapul, megvásárolható termékekre inkább 2012-ben és 2014-ben lehet csak számítani.

Az NVIDIA tehát továbbra is azt tűzte ki célul maga elé, hogy az eddig az Intelhez áramló dollármilliárdokból döntő szeletet hasítson ki magának, a hátsó ülésre szorítva az x86-os chipgyártót. Huang megerősítette, hogy a vállalat nem akarja felváltani az x86 processzorok szerepét, hanem masszívan párhuzamos felépítésű chipekkel kiegészíteni azokat, aminek következményeként egyúttal csökkenti azok jelentőségét. Huang elmondta, hogy az NVIDIA mérnökei azon dolgoznak gőzerővel, hogy az NVIDIA chipjeinek és a számítógépek teljesítménye egyre kevésbé függjön az x86 processzoroktól, a végrehajtás egyre inkább függetlenedjen.