Fontos fejlesztéssel bővült a Google vizuális keresője

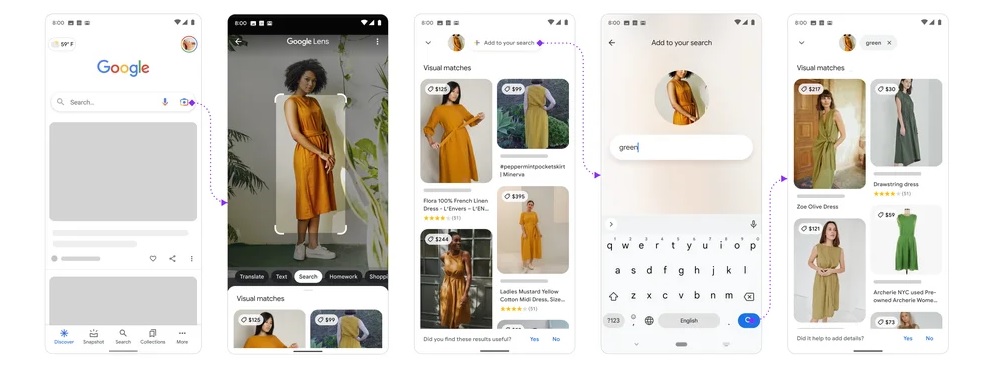

A Google bejelentette, hogy világszerte használhatóvá vált mobileszközökről a „multisearch” funkció, amivel a felhasználók vegyíthetik a képalapú és a szöveges keresést. A keresőcég először tavaly áprilisban beszélt a Google Lensbe épített fejlesztésről, ami a Multitask Unified Model (MUM) nevű MI-n alapul, és képes többféle formátumon keresztül értelmezni a keresések alapjául vett információkat, egyszerre tud dolgozni többek közt szövegekkel, fényképekkel és videókkal.

Tavaszi mix a 2025-ös IT pangástól az interjúk evolúciójáig Ezúttal öt IT karrierrel kapcsolatos, érdekes és aktuális témát érintettünk.

Így a netezők a Lens szolgáltatáson belül már szöveges kulcsszavakat is tudnak hozzáadni a pontosabb keresés érdekében a vizuális lekérdezésekhez, ehhez először érdemes megadni az appnak a fotót, majd a „Hozzáadás a kereséshez” opcióval utólag a szöveget.

A cég közleményében több gyakorlati példát is hoz arra, hogy ez mikor lehet hasznos: ha látunk egy mintát valahol egy ruhadarabon, vagy tapétán, befotózhatjuk, és a keresést a „póló” kulcsszóval kiegészítve a neten adott mintás pólókat találhatunk. Vagy befotózhatunk egy bútort, amihez alapesetben hasonló ajánlásokat kapunk a Lenstől, de ez most kibővül annak lehetőségével, hogy megadunk hozzá egy másik kívánt színt, vagy konkrét márkát is.

A következő pár hónap során a keresési mód elérhető lesz webes felületen is.